Новый этап в развитии экономической науки

В начале XXI века мир захлестнула волна разнообразных рейтингов. Сегодня рейтингуется всё и вся. Рейтингуются шахматисты, теннисисты, боксеры и футболисты; рейтингуются художники и их картины; рейтингуются коммерческие компании, футбольные клубы и политические лидеры, целые страны и их отдельные регионы, школы и университеты; рейтингуется деловой климат и экономический потенциал государств; рейтингуются даже сами рейтинги. В зону компетенции рейтингов попадают не только люди и зримые результаты их деятельности, но и трудноуловимые процессы и социальная обстановка. Составление рейтингов превращается в самостоятельную профессию, а сами рейтинги становятся предметов академических исследований. При этом в научных, собственно, как и в широких, кругах никто не обольщается насчет достоверности и объективности рейтингов; все понимают, что все рейтинговые оценки весьма условны и к ним нельзя относиться слишком серьезно. В то же время рейтинги превратились в самостоятельную силу: ими пользуются для принятия решений, они играют роль нового конкурентного инструмента.

В чем же причина столь широкого распространения рейтингов всех мастей и почему к ним столь противоречивое отношение?

Ответ на поставленный вопрос имеет эволюционное звучание. Дело в том, что на протяжении почти всей своей истории экономическая наука развивалась как наука количественная. И в этом направлении были достигнуты вполне зримые и впечатляющие успехи. Сегодня многие экономические параметры можно не только измерить с вполне приличной точностью, но и соединить между собой различными функциональными и статистическими зависимостями. Современная экономическая теория успешно провязывает между собой такие явления и показатели, как цены, доходы, издержки, налоги, инфляцию, процентные ставки, монопольная власть, капитал, ожидания, валютные курсы, производительность труда, заработки и т.п. При этом проблема качества до недавнего времени экономистами решалась довольно просто и утилитарно – они считали, что вся информация о рынке, в том числе о качестве товаров и услуг, заложена в цене. Следовательно, ценовая конкуренция автоматически содержала в себе и конкуренцию за качество продукции. Однако сегодня, в эпоху колоссального усложнения системы товарных рынков, простая связь между ценой и качеством нарушается – она становится либо неочевидной, либо вообще разрывается. Таким образом, на повестку дня выходит проблема измерения и оценки качества товаров и услуг. Без решения этой проблемы становится невозможным отследить рыночные искажения, которые в глобальной экономике могут достигать чудовищных размеров.

Отметим сразу, что под рыночными искажениями мы подразумеваем разрыв между ценой и рыночной оценкой качества. Малые искажения говорят об эффективности механизма ценообразования, большие – о его неудовлетворительной работе. Соответственно рыночные участники (субъекты) нуждаются в качественных характеристиках для того, чтобы предотвратить возможную переплату за те или иные товары и услуги. Причем если потребителю такая информация нужна для принятия решения о покупке товара, то производителю она нужна для проведения более разумной ценовой политики и для ликвидации недостатков в работе по обеспечению качества производимой продукции. Следовательно, качество товара (услуги) должно быть оцифровано в виде одного числа, которое могло бы быть сопоставимо с ценой.

Надо сказать, что сама идея рейтингования сложных рыночных объектов заложена в самом капитализме. Так, еще Э.Фромм проницательно подметил, что одна из особенностей капитализма состоит в сведении всего к количеству и абстракции [1, с.131]. При становлении эффективной системы обезличенного обмена все виды человеческого труда, все товары и услуги должны получить свою стоимостную оценку. Лишь после этого они могут «выйти» на рынок и участвовать в сделках. Подытоживая эту мысль Фромма, можно сказать, что капитализм осуществил тотальное оцифровывание окружающего мира. Все качественные признаки рыночных объектов «сжимаются» в одну количественную характеристику. Тем самым Э.Фромм вскрыл важный закон развития социальных систем – закон перехода качества в количество. Данное явление дополняет хорошо известные диалектические законы Г.Гегеля, в том числе закон перехода количества в качество. Следовательно, в реальной жизни имеет место двунаправленный процесс: развитие материального мира происходит в соответствии с гегелевским законом перехода количества в качество, тогда как его осмысление и включение в социальный кругооборот осуществляется в соответствии с фроммовским законом перехода качества в количество [2]. Процедура рейтингования сложных рыночных объектов прекрасно укладывается в закономерность, открытую Э.Фроммом.

Если говорить о феномене активизации рейтингового движения в начале XXI века, то он связан с принципиальным усложнением всей социальной жизни. Логика событий примерно такова: усложнившийся мир привел к его непониманию и недопониманию рыночными субъектами; непонимание или неадекватное восприятие мира порождает ошибки и большие рыночные искажения; наличие больших рыночных искажений генерирует экономические кризисы. Такое положение дел поставило перед экономической наукой новую задачу – систематически измерять качество сложных рыночных объектов. В настоящее время решение данной задачи видится в составлении разнообразных рейтингов. При всей инструментальной простоте рейтинговых методик можно говорить о новом этапе в развитии экономической мысли [3].

Следует сразу отметить тот факт, что все рейтинги обладают определенной однобокостью, содержат в себе массу условностей и неточностей. Довольно часто увлечение рейтингами может приводить к откровенным нелепостям. Более того, во многих случаях использование рейтингов приводит к активизации закона Ч.Гудхарта, который сам по себе является проявлением регулятивных искажений в социальной системе [6]. Почему же тогда рейтинговое движение продолжает процветать и развиваться?

Ответ на этот вопрос тривиален. При оценке качества сложных объектов у нас нет альтернативы рейтинговому инструментарию. Здесь ситуация примерно такая же, как в случае с эконометрикой и моделированием. Все модели воспроизводят мир условно и упрощенно, но другого способа исследования реальности у нас нет. Все эконометрические методы несовершенны, но иного способа установления системных связей у нас нет. То же самое и с рейтингами. Перефразируя известный афоризм, можно сказать, что лучше рейтинга может быть только другой рейтинг.

Система университетских рейтингов

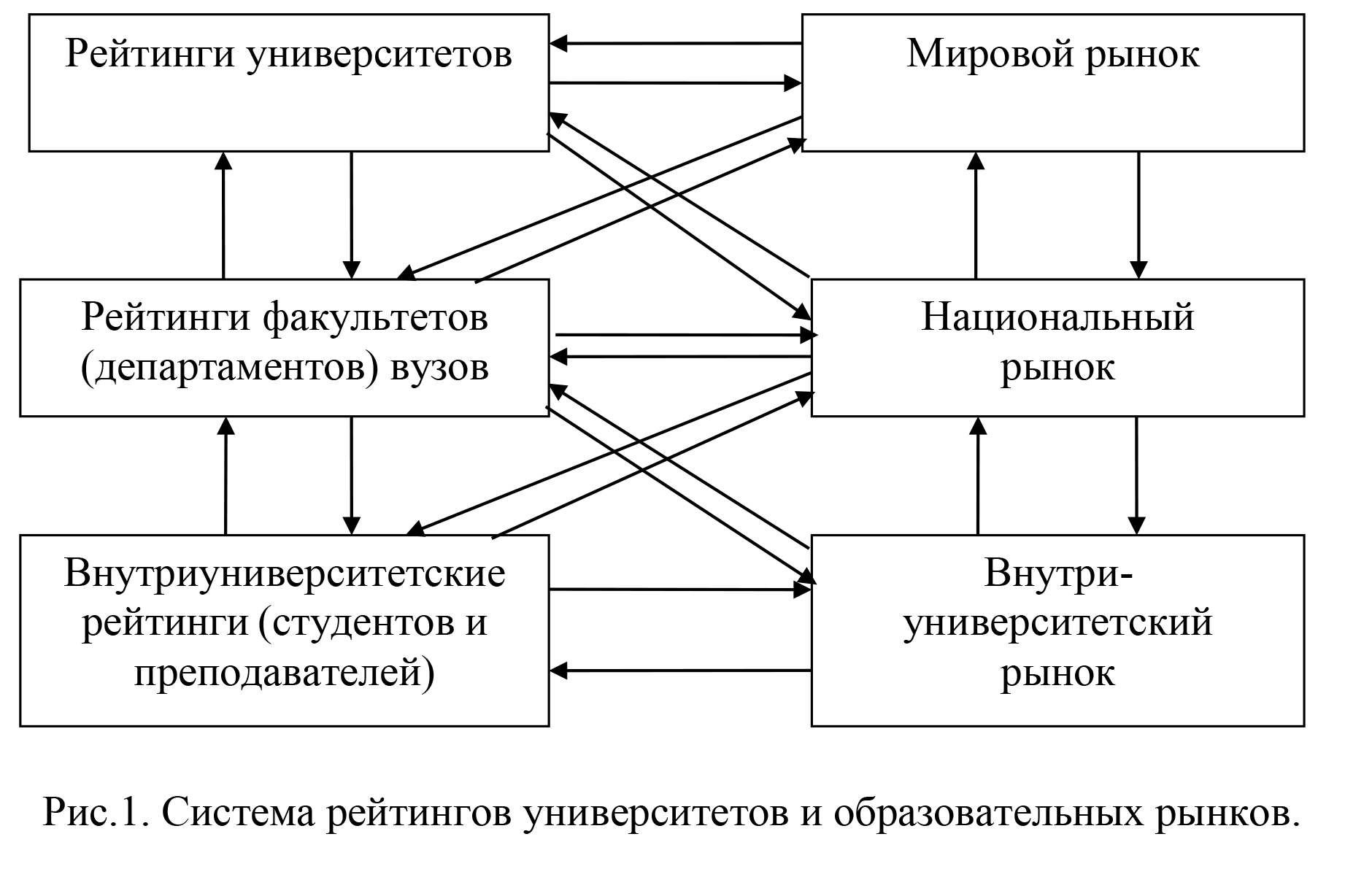

Наиболее ярким воплощением рейтинговой идеологии являются рейтинги университетов. Применительно к субъектам рынка образовательных услуг рейтинги играют двоякую роль. С одной стороны они фиксируют результаты конкуренции, с другой – выступают в качестве инструмента, стимулирующего конкурентные процессы на разных уровнях образовательного рынка. В настоящее время сформировалась трехуровневая система университетских рейтингов и образовательного рынка. Так, университеты, будучи крупными корпоративными образованиями, уже сами по себе представляют собой рынок, на котором конкурируют, по крайней мере, студенты и преподаватели; в российской системе особую конкурентную группу образуют администраторы. Чтобы инициировать внутригрупповую конкуренцию среди студентов и преподавателей в университетах используется сложная система критериев их оценки, которая в ряде случаев может принимать форму рейтинга. Таким образом, внутриуниверситетский рынок и внутриуниверситетские рейтинги являются исходной точкой университетской конкуренции, ее низовым звеном. Сюда же относится и конкуренция между факультетами (департаментами) одного вуза, хотя она редко принимает форму рейтинга.

На следующем уровне разворачивается конкуренция между профессиональными группами (факультетами) разных университетов на общенациональном рынке образовательных услуг. Итогом таких процессов являются рейтинги факультетов (департаментов) вузов одной страны. Для передовых факультетов такая конкуренция перерастает в международную, когда осуществляется сравнение факультета некоего профиля среди всех вузов мира. Аналогичные два уровня рынка – национальный и мировой – имеют место и для конкуренции университетов в целом. Результатом такой борьбы являются национальные и глобальные (международные) рейтинги университетов. Общая схема сопряжения образовательных рынков и рейтингов разных уровней приведена на рис.1.

Подобная система позволяет пронизать конкурентными процессами всю систему высшего образования – от учета деятельности каждого конкретного человека (студента и преподавателя) вуза до оценки его успеха как единой целостности, включая его отдельные части (факультеты). При этом в вузах-лидерах мирового рынка действует колоссальная система учета всех сторон университетской жизни, а вузы-аутсайдеры могут вообще не участвовать ни в каких рейтингах, довольствуясь своими низкими образовательными котировками.

В последнее время большую популярность приобрели глобальные рейтинги университетов (ГРУ), которым посвящена обширная литература; обзор данной проблематики приведен в работах [4-7]. Набирает обороты и практика составления национальных рейтингов университетов (НРУ); Россия подключилась к этому процессу. Однако большая неоднородность вузов приводит к тому, что ГРУ и НРУ оказываются довольно грубым ориентиром при оценке профессиональных успехов вузов и выборе абитуриентами специальности. Более тонкая калибровка образовательных успехов вузов сосредоточена в рейтингах университетских факультетов (РУФ), которые имеют гораздо меньшую общественную популярность, чем ГРУ и НРУ, и пока не нашли широкого распространения в российской практике. В связи с этим в данной работе нами будет представлен обзор практики составления и использования РУФ за рубежом.

Рейтинги университетских факультетов: практика составления

Ориентация абитуриентов при выборе профессии на данные ГРУ и НРУ может приводить к существенным ошибкам. Для иллюстрации этого тезиса приведем выборочные данные о месте ведущих университетов по разным научным направлениям (табл.1).

Таблица 1. Места ведущих университетов по некоторым дисциплинам в РУФ QS–WURS в 2011 г.

|

Научное |

Университет |

||||||

|

Оксфорд |

Кембридж |

Гарвард |

МТИ |

Университет Токио |

Университет Цюриха |

Университет Мельбурна |

|

|

Физика и астрономия |

3 |

1 |

2 |

4 |

11 |

10 |

14 |

|

Математика |

6 |

3 |

1 |

2 |

32 |

10 |

26 |

|

Медицина |

4 |

2 |

1 |

3 |

20 |

51-100 |

15 |

|

Экономика и эконометрика |

5 |

6 |

1 |

2 |

26 |

51-100 |

16 |

|

Право |

2 |

3 |

1 |

Нк* |

Нк* |

51-100 |

9 |

|

Философия |

2 |

3 |

1 |

14 |

Нк* |

Нк* |

15 |

|

География |

1 |

4 |

3 |

18 |

12 |

51-100 |

22 |

*Нк – данное направление не является профильным для университета, в связи с чем он либо не котируется в рейтинге, либо его котировки заведомо низкие.

Из табл.1 видно, что даже Массачусетский технологический институт (МТИ) не в состоянии удержать одинаковые позиции по всем дисциплинам. Например, если в математике он является фактически явным лидером (2-е место), то в области географии ему с трудом удается войти в 20 лучших вузов. Подобные различия возрастают по мере отдаления университета от узкой группы самых лучших вузов мира – «золотого ядра». Так, Университет Цюриха легко перемещается с 10-го места в своих «коронных» дисциплинах за 50-е место в прочих науках (табл.1).

Сегодня практика составления РУФ является довольно обширной. Рассмотрим некоторые самые популярные рейтинговые системы.

1. Рейтинг QS–WURS и его особенности

Один из ведущих британских разработчиков университетских рейтингов – Quacquarelli Symonds (QS) – имеет обширную практику не только в области ГРУ, но и в области РУФ. Данным ренкером [1] с 2005 г. разрабатывается множество факультетских рейтингов QS World University Rankings by Subject (QS–WURS), которые агрегируются в пять стандартных разделов, которые в свою очередь включают 26 научных дисциплин [8]. Так, выделяются следующие типовые разделы и научные направления: раздел искусство и гуманитарное знание (Arts & Humanities) включает философию (Philosophy), современные языки (Modern Languages), географию (Geography), историю (History), лингвистику (Linguistics), английский язык и литературу (English Language & Literature); раздел инженерия и технологии (Engineering & Technology) включает информатику (Computer Science), химическую промышленность (Chemical Engineering), гражданское строительство (Civil Engineering), электротехнику (Electrical Engineering) и машиностроение (Mechanical Engineering); раздел науки о жизни и медицина (Life Sciences & Medicine) включает медицину (Medicine), биологию (Biological Sciences) и психологию (Psychology); раздел естественные науки (Natural Sciences) включает физику и астрономию (Physics & Astronomy), металлургию и материаловедение (Metallurgy & Materials), математику (Mathematics), науки об окружающей среде (Environmental Sciences), науки о Земле и Море (Earth & Marine Sciences) и химию (Chemistry); раздел социальные науки и менеджмент (Social Sciences & Management) включает статистику и исследование операций (Statistics & Operational Research), социологию (Sociology), политологию и международные исследования (Politics & International Studies), право (Law), экономику и эконометрику (Economics & Econometrics) и бухгалтерию и финансы (Accounting & Finance).

Разумеется, данный список может быть дополнен неучтенными научными дисциплинами. Так, многолетние исследования компании QS позволили выявить 52 тематических области; в 2012 г. рейтинг QS–WURS в 2011 г. должен был охватить 29 научных направлений; оценка остальных дисциплин остается в качестве задачи на более отдаленную перспективу.

По сравнению с ГРУ РУФ строятся по усеченной методологии. Так, ГРУ и международные региональные рейтинги компанией QS строятся на основе 12 критериев оценки, однако для РУФ разработчик оставляет только 3 фактора: академическую репутацию, мнение работодателя и цитируемость.

Для оценки академической репутации используется следующая процедура опроса экспертов. Сначала академический эксперт сам определяет 1-2 узких направления своей научной дисциплины, в которых он сам себя считает специалистом. Затем он определяет не более 10 местных (своей страны происхождения) и 30 иностранных вузов, в которых его научное направление представлено наилучшим образом; при этом собственный вуз, в котором работает эксперт, он называть не может во избежание необъективности. Впоследствии учет мнения эксперта для вузов его страны ведется с весовым коэффициентом в 1/3, а для иностранных – с коэффициентом в 2/3.

Для оценки репутации вузов в глазах работодателя используется следующая процедура опроса. Сначала работодатель определяет не более 10 отечественных и 30 иностранных вузов, выпускников которых он предпочитает нанимать в силу их высокой профессиональной подготовки. Затем он определяет дисциплины (профессии), которые он предпочитает при найме рабочей силы. На пересечении данных сведений разработчик рейтинга определяет истинную меру качества выпускников соответствующих вузов по изучаемым дисциплинам. Разумеется, не у всех людей карьера напрямую связана с полученной профессией. Например, многие инженеры становятся бухгалтерами и т.п. Для учета этого факта используются дополнительные процедуры взвешивания ответов работодателей.

Для оценки среднего цитирования на одну статью факультета используются стандартные библиометрические процедуры учета цитирований в базе «Scopus». Специфика данного учета состоит в том, что анализ ведется только применительно к одной научной дисциплине; междисциплинарные публикации не учитываются.

По результатам оценки трех факторов все данные нормируются и взвешиваются. При этом в РУФ в отличие от обычных ГРУ используется система не фиксированных, а переменных (адаптируемых) весовых коэффициентов.

Система адаптируемых весов заключается в том, что разные научные дисциплины оцениваются по указанным трем группам факторов, но вес этих групп факторов для разных наук неодинаковый. Разработчики рейтинга справедливо указывают, что показатели публикуемости и цитируемости гораздо выше для наук о жизни и естественных наук, чем для социальных и гуманитарных наук и для искусства. Например, совсем не будет иметь смысла одинаковый акцент на показателях цитируемости при оценке медицинских наук и языкознания (литературы). Аналогичным образом варьируется популярность разных дисциплин среди предпринимателей. Так, совершенно неправомерным будет одинаковый акцент на мнении предпринимателей в отношении экономистов и философов. В связи с этим в рейтинге QS–WURS используется дифференцированная система весовых коэффициентов для разных научных дисциплин (табл.2). Кроме того, в указанном рейтинге используются разные выборки опрашиваемых экспертов и предпринимателей; такой подход можно назвать системой адаптируемой структуры выборки (табл.3).

Из табл.2-3 видно, что колебания весовых коэффициентов являются поистине огромными. Столь широкий диапазон колебания значимости разных факторов и экспертов свидетельствует с одной стороны о гибкости вычислительных алгоритмов рейтинга, а с другой – о высоком потенциале возможных ошибок.

Таблица 2. Зависимость весовых коэффициентов рейтинга QS–WURS от специфики научного направления.

|

Научное направление |

Вес фактора, % |

||

|

Оценка академической репутации |

Оценка работодателей |

Оценка цитируемости |

|

|

Биология, медицина, химия |

40 |

10 |

50 |

|

Исследования окружающей среды |

50 |

10 |

40 |

|

Экономика, психология |

50 |

30 |

20 |

|

География, статистика |

70 |

10 |

20 |

|

Языкознание |

70 |

30 |

0 |

|

История, социология, философия |

80 |

10 |

10 |

|

Английский язык |

90 |

10 |

0 |

|

Вариативность веса фактора |

40–90 |

10–40 |

0–50 |

Таблица 3. Зависимость структуры выборки респондентов рейтинга QS–WURS от специфики научного направления.

|

Научное направление |

Доля экспертной группы, % |

|

|

Академические эксперты |

Работодатели |

|

|

Бухгалтерия и финансы |

16,3 |

83,7 |

|

Экономика |

30,1 |

69,9 |

|

Право |

32,8 |

67,2 |

|

Физика |

86,7 |

13,3 |

|

Математика |

73,8 |

26,2 |

|

Биология |

83,9 |

16,1 |

|

Социология |

80,4 |

19,6 |

|

Химия |

63,4 |

36,6 |

|

Вариативность структуры выборки |

16,3–86,7 |

16,1–83,7 |

В рейтинговой системе QS–WURS производится построение глобальных (общемировых) и региональных (международных) РУФ. По всей видимости, в настоящее время РУФ QS–WURS является одной из наиболее авторитетных систем оценки качества образования на отдельных факультетах.

Можно также отметить, что британский ренкер Times Higher Education в сотрудничестве с агентством Thomson Reuters разрабатывает тематические рейтинги THE World University Rankings by subject (THE-WURS), предусматривающие следующие агрегированные области: инженерия и технологии (Engineering & Technology); искусство и гуманитарные науки (Arts & Humanities); клиническая медицина и здравоохранение (Clinical, Pre-clinical & Health); науки о Земле (Life sciences); физические науки (Physical sciences); социальные науки (Social sciences). Рейтинги сканируют все страны мира с итоговой таблицей Топ-50 [15]. Таким образом, некий аналог РУФ ренкер THE составляет, однако они являются обобщенными, не включающими отдельные научные дисциплины, и урезанными по количеству оцениваемых университетов. Методология составления рейтингов THE-WURS довольно сложная и совпадает с той, которая используется ренкером при разработке его ГРУ [4]. В целом же рейтинг THE-WURS можно считать в качестве «половинчатого» РУФ, который пока не имеет большой популярности среди университетских факультетов.

2. Рейтинг MDPR и его особенности

Надо сказать, что все РУФ можно условно разделить на простые и сложные. К разряду сложных правомерно отнести рейтинг QS–WURS, который предполагает разветвленную и нетривиальную процедуру сбора информации и ее последующей обработки. Однако есть и совсем простые алгоритмы составления РУФ. К числу таковых относится рейтинг Management Department Productivity Rankings (MDPR), который является совместным проектом двух американских университетов – Техасского университета сельского хозяйства и механизации (Texas A&M University; A&M – Agricultural and Mechanical) и университета Флориды (University of Florida) [9]. Данный рейтинг, начиная с 2005 года, ежегодно оценивает продуктивность факультетов менеджмента университетов США и Канады. Суть его состоит в том, что все факультеты оцениваются по тому, как они представлены в ведущих журналах по менеджменту, т.е. сколько статей сотрудников соответствующих факультетов размещается на страницах лучших специализированных изданий. При этом разработчиком рейтинга выбрано всего 8 журналов: Academy of Management Journal; Academy of Management Review; Administrative Science Quarterly; Journal of Applied Psychology; Organization Science; Organizational Behavior and Human Decision Processes; Personnel Psychology; Strategic Management Journal.

Примечательно, что рейтинг MDPR не предусматривает даже такого показателя, как цитируемость, ограничиваясь простым показателем публикуемости. Причем число публикаций не корректируется с учетом размера факультетов – дается их абсолютное значение. Иными словами, чем больше статей того или иного факультета (департамента), тем сильнее его влияние на информационное академическое пространство и тем лучше сам факультет. При этом не учитывается число авторов статей, т.е. действует принцип: одна статья университетского факультета дает один балл университету. Кроме того, разработчиком учитываются только факультеты менеджмента как таковые; факультеты психологии, промышленных связей и всевозможные бизнес-школы исключаются из информационной базы. Любопытно, что создатели MDPR сами указывают на то, что их рейтинг является лишь одним из возможных способов учета качества образования на соответствующих факультетах и не претендует на замену других методик.

Нельзя не отметить следующий факт – разработка рейтингов университетов ведется, как правило, либо специализированными агентствами (например, QS–WURS), либо университетами (например, MDPR). Если первые редко подозреваются в ангажированности, то университеты, будучи полноправными участниками рейтинга, почти всегда стараются использовать свое привилегированное положение ренкера для повышения своего статуса и места в турнирной таблице. Это положение полностью применимо и к случаю MDPR. Так, Texas A&M University и University of Florida, не относясь к разряду самых лучших вузов мира, в своем рейтинге систематически выступают в качестве лидеров; University of Florida в 2007 г. оказался даже на втором месте. В любом случае оба вуза, согласно агрегированному рейтингу MDPR, входят в десятку лучших университетов по специальности «Менеджмент» (табл.4). Таким образом, складывается впечатление, что вузы, составляющие рейтинг, за счет разных факторов и эффектов недвусмысленно завышают свое место в конкурентной иерархии. По всей видимости, именно это обстоятельство вкупе с имиджевой составляющей служит главным аргументом в пользу взятия университетом на себя трудоемкой работы по составлению рейтингов.

Таблица 4. Места университетов-разработчиков в рейтинге MDPR.

|

Университет |

2005 |

2006 |

2007 |

2008 |

2009 |

2010 |

2011 |

2005-2011 |

|

Texas A&M University |

4 |

8 |

7 |

3 |

26 |

3 |

5 |

6 |

|

University of Florida |

8 |

6 |

2 |

5 |

6 |

13 |

91 |

9 |

Вместе с тем было бы несправедливо упрекать вузы-ренкеры в заведомой необъективности. Например, Texas A&M University за период 2008–2009 гг. съехал с 3-го места на 26-е, а University of Florida по сравнению со 2-ым местом в 2007 г. упал до 91 места в 2011 г. (табл.4). Подобные провалы в собственном рейтинге свидетельствуют, по крайней мере, об отсутствии примитивной ангажированности университетов-разработчиков.

3. Рейтинг TUER и его особенности

С 2004 года Центр исследований в области экономики и бизнеса Университета Тилбурга (Tilburg University) готовит ежегодный рейтинг Топ-100 Tilburg University Economics Ranking (TUER) [10]. Причем для большей наглядности голландский Tilburg University подготовил ретроспективный рейтинг экономических факультетов ведущих университетов мира с 1990 г. Как и во всех подобных случаях, Tilburg University использует свою позицию разработчика рейтинга для улучшения своих позиций. Так, с 2004 г. он занимал двадцатые и тридцатые места, а в 2011 г. вышел на 15-е место.

Методология рейтинга TUER похожа на методологию рейтинга MDPR, но применяется она с большим размахом. Так, в TUER используется та же процедура рейтингования в зависимости от степени публикуемости сотрудников соответствующих университетских факультетов. При этом база учитываемых журналов включает 70 изданий в области эконометрики, экономики и финансов. Из этой базы Ассоциацией университетов Голландии в 2008 г. было выбрано «активное» подмножество из 36 журналов для непосредственного учета в рейтинге TUER. Учет публикаций ведется за последние 5 лет. При желании пользователь может путем комбинации управляющих опций на сайте университета Тилбурга построить индивидуальный рейтинг, который может основываться на любой выборке, включая требуемый регион мира, год, подмножество журналов (в том числе и полное множество из 70 журналов).

Расчет рейтинга ведется по упрощенной схеме: все журналы имеют одинаковый вес; учитываются только оригинальные статьи, тогда как обсуждения и комментарии к статьям не учитываются; принадлежность авторов к соответствующему университетскому факультету определяется на момент публикации статьи, т.е. текущий статус автора не учитывается; наличие нескольких авторов одного университета не учитывается и дополнительных баллов данному вузу это не дает; корректировки данных с учетом размера института не производится. Кроме того, ренкер TUER не использует показатели цитируемости (импакт-факторы). Это связано с двумя обстоятельствами. Во-первых, из-за нарастающей критики аналитической корректности импакт-факторов, во-вторых, из-за желания сохранить максимальную простоту и прозрачность рейтинга. Однако, по мнению специалистов TUER, использование показателей цитируемости вместо показателей публикуемости не ведет к серьезным изменениям результатов рейтингования [10].

Общая аргументация аналитиков TUER вполне понятна и справедлива, однако последний тезис можно взять под сомнение. Здесь уместно сослаться на исследование Дж.Л.Мэтсона и его коллег по оценке значимости показателей публикуемости и цитируемости при рейтинговании докторских программ университетов США в области клинической психологии [11]. Как оказывается, данные два показателя генерируют принципиально различающиеся рейтинги. Данный факт даже спровоцировал исследовательскую группу Дж.Л.Мэтсона на построение двух независимых рейтингов по показателям публикуемости и цитируемости с их последующим суммированием для получения композитного индекса качества факультетов [11]. Тем самым два основополагающих академических показателя – публикуемость и цитируемость – в большинстве случаев оказываются в остром противоречии. Частично это противоречие устраняется путем совместного учета обоих факторов, однако большинство РУФ такой процедуры не предусматривает. Этот недостаток делает подавляющее большинство факультетских рейтингов несколько условными.

4. Рейтинг UTD–BSRR и его особенности

Рейтинг TUER возник во многом как ответ на наличие таких авторитетных университетских рейтингов, как UTD–BSRR и ASU–FR. Рассмотрим сначала первый из них, который разрабатывается с 1990 года Школой менеджмента (Naveen Jindal School of Management) Университета Техаса в Далласе (University of Texas, Dallas – UTD), США. Это исследовательский рейтинг, который ранжирует лучшие бизнес-школы мира и виде Топ-листа The UTD Top 100 Business School Research Rankings (UTD–BSRR) [12].

Данный рейтинг мало чем отличается от предыдущих РУФ. Он учитывает публикуемость работников университетских бизнес-школ в 24 ведущих журналах по различным бизнес-дисциплинам за последние 5 лет. Единственным отличием здесь является более изощренный алгоритм начисления баллов за соответствующие публикации. Так, за статью, написанную одним автором, соответствующему университетскому факультету начисляется 1 балл. Если статья написана несколькими авторами из разных вузов, то каждый институт получает человеко-балл в размере 1/n, где n – число авторов из одного института. Учитываются также и случаи, когда автор указывает несколько мест работы, одновременно принадлежа к нескольким школам. Например, если один из n авторов указывает m мест работы, то каждый институт от данного автора получает 1/nm баллов. Подчеркнем, что баллы институту начисляются за каждого автора, после чего суммируются.

На примере рейтинга UTD–BSRR также очень хорошо проявляются ранее отмеченные закономерности. Во-первых, университет-ренкер, как правило, входит в число университетов-лидеров, во-вторых, ренкер, по мере составления своего рейтинга, прекрасно к нему адаптируется и продвигается в нем в разряд явных лидеров. Например, анализируя доступную базу данных имеющихся рейтингов с 2000-2004 гг. по 2007-2011 гг., можно видеть, что UTD за 7 лет проделал следующее ралли в сторону первых позиций: 40→36→35→21→18→17→16→16. По всей видимости, в основе такого эффекта лежит процесс настройки всей научной жизни университетского факультета на те критерии и показатели, которые используются в их «родном» рейтинге. Знание сотрудниками вуза системы рейтингования приводит к более эффективным действиям на научном информационном поле.

5. Рейтинг ASU–FR и его особенности

Еще одним РУФ, ставшим достаточно популярным, является рейтинг, разрабатываемый с 1990 г. Университетом Аризоны (Arizona State University – ASU), США. Данный рейтинг направлен на ранжирование факультетов финансов ведущих университетов мира в виде таблицы ASU Finance Rankings (ASU–FR) и опирается на ту же методологию, что и рейтинги MDPR, TUER, UTD–BSRR [13]. Как правило, число вузов в рейтинге не превышает 125.

Рейтинг ASU–FR относится к разряду, пожалуй, самых простых, т.к. базируется на учете числа опубликованных статей только в четырех ведущих журналах: Journal of Finance; Journal of Financial and Quantitative Analysis; Journal of Financial Economics; Review of Financial Studies; Financial Management. При этом ведется погодовой учет опубликованных статей, однако при желании можно составлять и кумулятивные рейтинги за ряд лет. Все данные доступны с 1990 года включительно.

Характерным для данного рейтинга является то, что его разработчик не очень удачно вписывается в свои же собственные стандарты. Так, в 1990 г. ASU занимал в своем рейтинге 30-е место, в 2000 г. – 25-е, в 2005 г. – 16-е, а в 2011 г. – 61-е. В среднем за период времени 1990-2011 гг. ASU занимает 45-е место в рейтинге ASU–FR. Тем самым ASU все равно, как правило, входит в лучшие 30-40 вузов в области финансов, но его положение неустойчиво. На наш взгляд, эта неустойчивость вызвана слишком скудной академической базой сравнения – 4 журнала представляют все-таки слишком узкое информационное поле для конкуренции вузов из всех стран мира. В каком-то смысле можно говорить, что ASU, упав в «родном» рейтинге, попал в свою собственную ловушку. В связи с этим не будет ошибкой утверждение о том, что база ведущих журналов для сравнения академических успехов исследователей должна состоять, по крайней мере, из 8–10 изданий.

6. Рейтинг ARWU-S и его особенности

С 2003 года функционирует авторитетный рейтинг The Academic Ranking of World Universities (ARWU), который разработан Центром университетов мирового класса и Институтом высшего образования Шанхайского университета Джао Тонг (Shanghai Jiao Tong University). С 2003 г. китайский университет Shanghai Jiao Tong University публикует ГРУ, но начиная с 2007 г. он начинает обнародовать рейтинги университетов по областям знания ARWU-FIELD (ARWU-F), а с 2009 г. – по конкретным научным направлениям ARWU-SUBJECT (ARWU-S) [14]. Наибольший интерес для нас представляют РУФ ARWU-S, которые включают такие пять дисциплин, как математика, физика, химия, информатика, экономика/бизнес.

Методология составления ARWU-S и ARWU-F практически едина, имеются лишь незначительные отличия. Методики ARWU-S в зависимости от научных дисциплин также мало различаются. В связи с этим рассмотрим для примера методику для дисциплины «Экономика/бизнес». Учет ведется по пяти группам показателей; внутри группы университет-лидер получает 100%, а остальные вузы получают процентную оценку относительно лидера. Впоследствии все пять показателей суммируются с помощью системы весовых коэффициентов: выпускники университета, получившие высшие награды (Нобелевскую премию) – весовой балл 10%; сотрудники вуза, получившие во время работы в вузе научные призы (медаль Тьюринга) – балл 15%; число высоко цитируемых исследователей вуза по 20 специальным направлениям – балл 25%; число статей, индексированных в системах Science Citation Index и Social Science Citation Index за предыдущие 2 года – балл 25%; процент статей, опубликованных в передовой части (20%) специализированных журналов – балл 25%.

Особый интерес в данной методике представляет расчет эффекта по двум первым группам с учетом его убывания во времени. Так, выпускники вуза определяются как те, кто получил в нем степени бакалавра, магистра или доктора. При этом устанавливается разный вес в зависимости от периода получения степени. Вес в 100% действует для выпускников 1991-2000 гг., 80% – для выпускников 1981-1990 гг., 60% – для выпускников 1971-1980 гг., 40% – для выпускников 1961-1970 гг., 20% – для выпускников 1951-1960 гг. Таким образом, с помощью системы понижающих коэффициентов учитывается эффект «забывания» заслуг университета. Если человек получает в вузе больше одной степени, то начисление баллов для вуза осуществляется все равно только один раз.

Аналогичным образом работает алгоритм для второй группы, состоящей из людей, работающих в вузе в момент получения награды. Здесь также устанавливается разная шкала в зависимости от периода получения приза. Вес в 100% действует для победителей 2001-2009 гг., 80% – для победителей 1991-2000 гг., 60% – для победителей 1981-1990 гг., 40% – для победителей 1971-1980 гг., 20% – для победителей 1961-1970 гг. Если призер является представителем нескольких учреждений, то каждое из них получает равную обоюдную выгоду (балл). Если, например, Нобелевскую премию получают несколько человек, то каждый победитель получает свою долю в соответствии с официальной наградой.

Примечательно, что Shanghai Jiao Tong University представляет собой практически уникальный пример того, когда университет, разрабатывая многочисленные рейтинги, сам не попадает в их верхние позиции. Так, среди пяти дисциплин в ARWU-S Shanghai Jiao Tong University только в области информатики занимал в 2010 году 76-100 место; в остальных рейтингах он вообще не фигурировал в списках Топ-100. Такое отстраненное отношение вуза к разрабатываемым рейтингам можно объяснить только тем, что он отыгрывает не столько свои собственные, сколько общенациональные интересы, показывая место ведущих китайских университетов на мировом рынке высшего образования.

Из сказанного несложно видеть, что рейтинг ARWU-S относится к разряду сложных, ибо его составление сопряжено с большой работой по сбору и обработке разнородных данных.

7. Проблема несогласованности рейтингов

Выше было показано, что методология составления рейтингов в каждом конкретном случае сильно варьируется. Как следствие, это приводит и к сильным различиям в самих рейтинговых оценках. Для конкретизации этого тезиса приведем данные о том, какие места имеют университеты-ренкеры в похожих рейтингах. Для этого составим табл.5, в которой по вертикали указаны университеты-ренкеры, а по горизонтали – разработанные ими рейтинги. При этом сравниваемые рейтинги являются «родственными», ибо охватываемые ими специальности относятся примерно к одной группе дисциплин – финансы, экономика, бизнес, менеджмент.

Таблица 5. Места университетов в рейтингах Топ-100 по «родственным» дисциплинам, 2010 г.

|

Университеты |

Рейтинги |

||||

|

ARWU-S |

ASU–FR |

UTD–BSRR |

TUER |

MDPR |

|

|

Shanghai Jiao Tong University |

НР* |

НР |

НР |

НР |

НР |

|

Arizona State University |

22 |

61–82 |

24 |

56–59 |

8–9 |

|

University of Texas, Dallas |

40 |

45–60 |

16 |

НР |

22–28 |

|

Tilburg University |

51–77 |

12–18 |

41 |

28–32 |

НР |

|

Texas A&M University |

42 |

83–100 |

31 |

НР |

3 |

|

University of Florida |

51–77 |

28–34 |

30 |

89–97 |

13–15 |

*НР – нет в рейтинге Топ-100.

Из табл.5 видно, что говорить о согласованности университетских рейтингов не имеет смысла, т.к. места вузов в них сильно разнятся. Некоторые университеты, имея передовые места в одних рейтингах, вообще выпадают из листа Топ-100 в других рейтингах. Данный факт говорит об узкой специализации существующих РУФ, что, в свою очередь, не позволяет делать на их основе серьезные обобщения о качестве образования в рейтингуемых вузах.

8. Рейтинг GBR и его особенности

Как уже отмечалось, помимо университетов, рейтинги разрабатывают специальные агентства и компании. Среди таковых присутствует компания Google, имеющая в своем арсенале рейтинг Google-based Ranking for Computer Science and Engineering Departments (GBR), который направлен на определение лучших университетских факультетов США в области информатики и компьютерного проектирования [16]. Результатом рейтингования является список из 26-27 научных школ передовых американских университетов.

Методология GBR основана на учете поисковых запросов в системе Google по следующим ключевым словосочетаниям: Computer Science, Computer Sciences и Computer Engineering. Второй запрос во множественном числе обусловлен некоторыми историческими традициями и обстоятельствами учета данной специальности. Подробное изложение разветвленной поисковой технологии Google дано в [17].

Аналитики Google провели беглое сравнение своего рейтинга с аналогичным рейтингом U.S. News and World Report rankings (USN-WRR). Как оказалось, данные два рейтинга дают довольно хорошо согласующиеся результаты, однако при этом обращает на себя внимание тот факт, что позиции Массачусетского технологического института и Вашингтонского университета в USN-WRR несколько завышены, тогда как Университет Висконсина явно недооценен. При этом автором заметки о рейтингах и апологетом рейтинга GBR является сотрудник Университет Висконсина Р.Арпачи-Десо (Remzi Arpaci-Dusseau) [16]. Тем самым и рейтинг GBR неявно способствует завышению места университета, который участвует в создании рейтинга.

Надо сказать, что GBR представляет собой так называемый Интернет-рейтинг и радикально отличается от прочих РУФ.

9. Рейтинг REPEC-ED и его особенности

Рейтингом гибридного типа, объединяющего в себе элементы веб-рейтинга GBR и обычных академических рейтингов типа TUER, является рейтинг экономических департаментов и институтов Research Papers in Economics (REPEC) – Economics Departments Rankings (REPEC–EDR) [18]. Данный рейтинг позволяет проранжировать все экономические факультеты университетов США [19], включая факультеты аграрной экономики [20], и все экономические институты мира [21]; присутствуют в нем и ведущие российские экономисты и институты [22]. Проект REPEC–EDR является результатом объединения усилий сотен волонтеров и научных организаций более чем из 75 стран мира. Их усилия направлены на повышение доступности результатов научных исследований в области экономики и смежных наук. Основой проекта является децентрализованная база данных по рабочим документам, статьям, книгам (главам) и программным продуктам. Сегодня проект REPEC включает 33 тыс. авторов, а вся его база организована и администрируется исследовательским отделом Федерального Резервного банка Сент-Луиса (Federal Reserve Bank of St. Louis), США. Непосредственное администрирование базой возложено на К.Циммермана (Christian Zimmermann).

Проект REPEC вышел из созданного в 1992 году проекта NetEc и получил поддержку в 1996-1999 годах от Комитета по объединенным информационным системам (Joint Information Systems Committee) Великобритании при Совете по финансированию высшего образования. С самого начала REPEC был частью Электронных библиотек (Программа eLib) и окончательно был создан в июне 1997 года с целью децентрализации проделанной работы.

В REPEC–EDR имеется мощная система ранжирования научных текстов по разным критериям: по частоте цитирования, загрузки и абстрактного просмотра [18]. Во всех случаях имеется возможность строить рейтинги по регионам, странам мира, авторам, статьям, экономическим институтам и т.п. В настоящее время в REPEC вычисляется 31 рейтинг в соответствии с 31 критерием. Так как REPEC ведет интернациональная группа, не принадлежащая к какой-то конкретной организации, то рейтинги REPEC–EDR являются менее ангажированными по сравнению с РУФ, разрабатываемыми университетами.

Классификация университетских рейтингов

Разумеется, рассмотренные выше РУФ не исчерпывают всей практики в этой области. Между тем они позволяют понять основные тренды в области оценивания качества образования по конкретным научным направлениям. Опыт показывает, что все рейтинги могут подразделяться в соответствии с прозрачной классификацией. Все они могут быть относительно простыми и сложными и разрабатываться либо независимыми группами (компаниями), либо университетами (табл.6).

Таблица 6. Классификация РУФ.

|

Уровень |

Тип ренкера |

|

|

Независимые |

Университеты |

|

|

Простые |

– |

MDPR, TUER, |

|

Сложные |

QS–WURS, |

ARWU–S |

Из табл.6 хорошо просматривается довольно очевидная закономерность: университеты тяготеют к простым рейтингам, тогда как специализированные компании (группы) – к более сложным методикам и алгоритмам. В связи с этим РУФ, разрабатываемые университетами, являются более понятными и наглядными, но в них почти всегда присутствуют интересы самого ренкера по продвижению себя на Топ-позиции. Рейтинги, разрабатываемые независимыми компаниями, как правило, более объективны, но менее наглядны и понятны. Таким образом, выбор методологии РУФ остается открытой темой для исследований и дискуссий.

Для реалий современной России более перспективным представляется путь составления РУФ ведущими вузами страны. При этом методики рейтингов должны быть максимально прозрачными и сопровождаться детальным обнародованием их информационного наполнения. Только в этом случае подобные РУФ не будут вызывать деструктивной критики, вызывая доверие потребителей.

Литература

1. Фромм Э. Здоровое общество. Догмат о Христе. М.: АСТ: Транзиткнига, 2005.

2. Балацкий Е.В. Когнитивно-институциональный синтез Д.Норта// «Общественные науки и современность», №5, 2011.

3. Балацкий Е.В. За пределами «экономического империализма»: преодоление сложности// «Общественные науки и современность», №4, 2012.

4. Балацкий Е.В., Екимова Н.А. Международные рейтинги университетов: практика составления и использования// «Журнал Новой экономической ассоциации», №9, 2011.

5. Балацкий Е.В., Екимова Н.А. Сравнительная надежность глобальных рейтингов университетов// «Журнал Новой экономической ассоциации», №11, 2011.

6. Балацкий Е.В., Екимова Н.А. Глобальные рейтинги университетов: проблема манипулирования// «Журнал Новой экономической ассоциации», №1(13), 2012.

7. Балацкий Е.В., Екимова Н.А. Условия формирования российских университетов мирового класса// «Общество и экономика», №7-8, 2012.

8. QS World University Rankings by Subject 2011 (http://www.topuniversities.com/university-rankings/world-university-rankings/2011/subject-rankings/).

9. Management Department Productivity Rankings (http://mays.tamu.edu/mgmt/productivity-rankings/).

10. The Tilburg University Top 100 Worldwide Economics Schools Research Ranking based on research contribution 2007-2011 (https://econtop.uvt.nl/rankinglist.php).

11. Matson J.L., Malone C.J., Gonzalez M.L., McClure D.R., Laud R.B., Minshawi N.F. Clinical psychology Ph.D. program rankings: evaluating eminence on faculty publications and citations// «Research in Developmental Disabilities», №.26, 2005, p.503–513.

12. The UTD Top 100 Business School Research Rankings (http://jindal.utdallas.edu/the-utd-top-100-business-school-research-rankings/).

13. Finance Rankings (http://wpcarey.asu.edu/fin-rankings/rankings/results.cfm).

14. Academic Ranking of World Universities in Economics/Business – 2010 (http://www.arwu.org/SubjectEcoBus2010.jsp).

15. Top 50 Social Sciences universities (http://www.timeshighereducation.co.uk/world-university-rankings/2011-2012/social-sciences.html).

16. Google-based Ranking for Computer Science and Engineering Departments (http://pages.cs.wisc.edu/~remzi/rank.html).

17. Факторы ранжирования Google 2009. Часть 1. – Google ranking factors (http://www.sundrop.name/2009/08/google-2009-1-google-ranking-factors.html).

18. RePEc/IDEAS rankings (http://ideas.repec.org/top/).

19. Top 25% US Economics Departments, as of August 2012 (http://ideas.repec.org/top/top.usecondept.html).

20. Top 25% Agricultural Economics Departments, as of August 2012 (http://ideas.repec.org/top/top.agecon.html).

21. Top 10% Economic Institutions, as of August 2012 (http://ideas.repec.org/top/top.inst.all.html).

22. Top 25% Institutions and Economists in Russia, as of August 2012 (http://ideas.repec.org/top/top.russia.html#authors).

[1] Под ренкером понимается разработчик рейтинга. Данный термин уже вошел в число общеупотребимых, а профессия ренкера стала уже общепризнанной.

Официальная ссылка на статью:

Балацкий Е.В. Мировой опыт составления и использования рейтингов университетских факультетов// «Общество и экономика», №9, 2012. С.155-173.