1. Введение: истоки проблемы

Оценка качества научных экономических журналов (НЭЖ) в России имеет свою историю, которая связана с двумя обстоятельствами тектонического масштаба. Первое: крушение СССР в 1991 г. привело к деиндустриализации России, в связи с чем наука и высшее образование потеряли свою былую востребованность и начали активно деградировать. Второе: демократизация информационного пространства страны и развитие цифровых технологий привело к бесконтрольному массовому возникновению новых научных журналов. Сочетание двух указанных трендов довольно быстро привело к переполнению рынка НЭЖ некачественными периодическими изданиями. Так, по состоянию на 14.04.2016 в российской базе данных eLIBRARY было зарегистрировано 926 отечественных НЭЖ, 11.04.2019 число отечественных НЭЖ возросло до 1281 издания, а к 18.01.2021 – до 1371. Таким образом, в настоящее время рынок российских НЭЖ стал в буквальном смысле слова необозрим. Совершенно очевидно, что подавляющая часть зарегистрированных в eLIBRARY журналов не отвечает современным научным стандартам, в связи с чем возникло своеобразное движение по выявлению среди них действительно достойных изданий. Аналогичный процесс был присущ не только России, но и почти всем странам мира, включая наиболее развитые из них.

Важность оценки качества НЭЖ детерминируется также тем обстоятельством, что периодические издания все чаще выступают в качестве информационной основы для формирования других систем ранжирования – персон (экономистов) и исследовательских организаций (институтов, университетов, лабораторий и т.п.).

Цель статьи состоит в обзоре существующих на сегодняшний день методов оценки качества НЭЖ, включая критический разбор их достоинств и недостатков. При этом акцент делается на российском рынке периодических изданий, однако по мере необходимости будет использован опыт и других стран.

2. Типология методов измерения качества НЭЖ

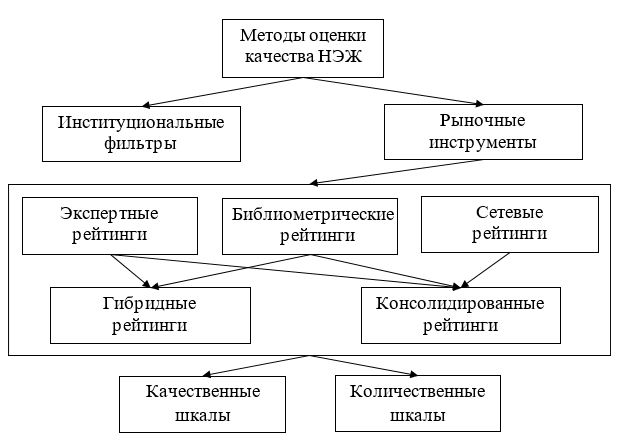

Оценка качества НЭЖ является чрезвычайно сложной задачей, не имеющей однозначного решения. Это связано с многосторонностью научной деятельности и многоаспектностью рынка научных исследований, что порождает проблему многокритериальности, размытости и условности оценок качества журналов. Указанные особенности НЭЖ предопределяют широкую палитру методов оценки их качества, которые с некоторой степенью условности можно представить в виде простой типологии (рис. 1). Согласно рисунку 1, все методы можно разделить на легитимные, которые представляют собой своего рода институциональные фильтры, вводимые на правительственном уровне, и рыночные, которые основаны на различных аналитических подходах и, строго говоря, не являются официальными, формируясь внутри научного сообщества представителями этого сообщества. Если первые базируются на власти государственного регулятора, то вторые – на авторитете экспертных групп.

Институциональные фильтры представляют собой правила, установленные органами государственной власти и регламентирующие статус НЭЖ. В соответствии с данными правилами тот или иной журнал выполняет их и получает оговоренный статус, в противном случае он его не получает. Рыночные методы могут быть трех видов. Первые – экспертные – основаны на опросах авторитетных специалистов в соответствующей науке относительно качества тех или иных НЭЖ. Число оцениваемых аспектов деятельности издания не регламентировано, но все они впоследствии агрегируются в итоговую оценку качества. Данный подход относится к числу субъективных, что частично сглаживается большим числом вовлекаемых в опрос экспертов. Вторые – библиометрические – основаны на учете библиометрических параметров журнала в той или иной электронной базе данных. Число оцениваемых параметров также не регламентируется, и все они, как правило, в итоге агрегируются в скалярную оценку качества. Данный подход относится к числу объективных, т.е. исключает предвзятость мнений экспертов, но позволяет манипулировать показателями соответствующей базы данных. Третьи – сетевые – основаны на специализированных вычислительных алгоритмах, позволяющих максимально правильно промаркировать исследуемое множество НЭЖ.

Рис. 1. Типология методов оценки качества НЭЖ

Так как все три вида рыночных метода оценки НЭЖ имеют свои специфические недостатки, то на практике часто используют гибридные схемы, которые объединяют процедуры разных подходов в рамках одного вычислительного алгоритма. Пропорции, в которых «смешиваются» различные рыночные методы, могут быть сколь угодно разными. Преимущество гибридных методов состоит в учете объективных и субъективных характеристик НЭЖ, что повышает надежность получаемых результатов. Аналогичную цель преследуют консолидированные схемы, которые представляют собой своеобразное усреднение нескольких однотипных или разнотипных турнирных списков журналов, что позволяет сглаживать симпатии и антипатии их разработчиков.

К сказанному можно добавить, что все статусные списки (рейтинги) могут быть основаны либо на количественных, либо на качественных маркерах НЭЖ. В первом случае издание получает количественную меру, позволяющую проранжировать журналы в виде рейтинга с указанием их места в итоговом списке, во втором – все издания распределяются на несколько групп, которым присваивается разный статус качества (научного уровня) в виде условного кодового обозначения. Ниже мы более подробно рассмотрим все указанные разновидности оценки качества НЭЖ. Однако подчеркнем особо, что все существующие методы, в конечном счете, направлены на определение приоритетности и предпочтительности периодических изданий, т.е. наибольший интерес вызывают только лидеры рейтинговых топ–листов.

3. Наукометрические методы построения рейтингов НЭЖ

Первые рейтинги НЭЖ, основанные на анализе цитирования, появились во второй половине ХХ века, когда были разработаны механизмы ранжирования научных документов, учитывающие библиометрические показатели. Основным инструментом для получения данных стал индекс научного цитирования Science Citation Index, созданный в США в 1961 г.

Ранние исследования были основаны на простых методах измерений цитирования. Для оценки качества журналов использовались библиографии статей, опубликованных в небольшом количестве изданий. Формируемые перечни журналов получались весьма ограниченными по объему, что было обусловлено большой трудоемкостью процесса обработки библиометрической информации, осуществляемого вручную (Бредихин и др., 2013). Так, один из первых рейтингов НЭЖ включал всего 10 журналов, список которых опубликовал в 1971 г. Альфред Коутс (Coats, 1971). В качестве критерия для формирования перечня журналов Коутс применил число цитирований на статьи в обзорах Американской экономической ассоциации (AEA survey volumes).

В нескольких работах для определения качества изданий использованы ссылки на них из пула «основных» журналов. Примером такого подхода является попытка Брэдли Биллингса и Джорджа Викснинса провести оценку и ранжирование 50 НЭЖ на основе анализа цитирований из трех изданий – American Economic Review, Econometrica и Economic Journal (Billings, Viksnins, 1972). Недостаток их метода состоял в произвольном выборе «эталонных» журналов, ссылки из которых применялись для оценки.

Рассматривая цитаты как некоторый показатель качества статьи, Уинстон Буш, Пол Гамельман и Роберт Стааф применили их для получения специального индекса и на его основе составили рейтинг из 14 НЭЖ. Методика заключалась в подсчете числа цитирований, которое получил каждый из 14 журналов от самого себя и из остальных 13 изданий (Bush, et al., 1974).

Простые методы библиометрического анализа стали основой исследований, предлагающих в качестве альтернативных критериев для оценки журналов источники, которые используются не только в профессиональной научной среде, но и в более широком сообществе. Так, в 1972 г. Джек Скилз и Райланд Тэйлор составили ранжированный перечень из 35 НЭЖ, проведя количественный анализ списков статей, рекомендованных для чтения студентам вузов (Skeels, Taylor, 1972), а в 2002 г. Гейнс Линер сформировал ядро из 30 НЭЖ по их цитируемости в 6 основных учебниках по микроэкономике, макроэкономике и эконометрике, отобранных на основе опроса профессоров ведущих экономических факультетов университетов США (Liner, 2002).

Слабые стороны используемых методов простого подсчета цитирований из определенной группы источников для выделения наиболее цитируемых журналов заключаются как в произвольности выбора самих источников, так и в том, что авторы рейтингов не учитывают при их составлении такие важные критерии для анализа цитирования, как объем и возраст журналов. Попытки нивелировать последний недостаток были связаны с выработкой методов ранжирования журналов, позволяющих учитывать в анализе цитирования дополнительные характеристики изданий.

Прорывом в развитии методологии оценки НЭЖ стало создание международных научных баз данных (МНБД) и выпуск с 1972 г. указателя цитируемой литературы по общественным наукам – Social Science Citation Index (SSCI). С появлением этого инструмента исследователи получили доступ к исчерпывающей информации о цитировании большого массива научной периодики, следовательно, и возможность проводить ранжирование большого числа журналов. Применение новых подходов к анализу цитирования и оценке научных журналов обусловило разработку новых рейтингов, в том числе основанных на учете объема и индикаторов влиятельности статей, престижности научных журналов. Большое влияние на развитие рейтингового движения оказал ежегодный выпуск с 1975 г. Указателя цитируемости научных журналов (Journal Citation Reports), содержащего информацию об импакт–факторах журналов, в том числе включенных в SSCI (Garfield, 1973). Показатель, предложенный Юджином Гарфилдом (Garfield, 1955), обеспечивающий возможность сравнения журналов по вероятности их цитирования, очень быстро набрал популярность как символ научного престижа журнала, хорошо коррелирующий с мнением ученых о лучших журналах в их дисциплинах (Hoeffel, 1998).

Многочисленные попытки преодолеть методологические ограничения импакт–фактора, в частности его неспособность учитывать влиятельность разных источников, из которых приходят ссылки, привели к использованию более сложных методов, основанных на взвешивании цитирований из журналов разных уровней. Первыми значительно улучшенный метод предложили Саймон Либовиц и Джон Палмер (Liebowitz, Palmer, 1984), которые проранжировали 108 НЭЖ за счет учета относительного влияния опубликованных в них статей. В качестве параметров измерения влияния было использовано число цитирований каждого журнала, полученное в 1980 г., на материалы, опубликованные в предыдущие годы. Отличие от предыдущих рейтингов состояло в том, что разработчики стандартизировали издания, чтобы компенсировать различия в их объеме и возрасте, а также применили итеративную схему для взвешивания цитат, полученных из различных журналов, что позволило «вычистить» цитаты из неэкономических изданий.

Метод Либовица и Палмера был использован спустя десять лет Девидом Лабандом и Майклом Пьеттом для ранжирования уже 130 НЭЖ (Laband, Piette, 1994). Итерационный метод для вычисления импакт–факторов 159 НЭЖ с учетом качества, т.е. престижа цитирующих изданий, возраста и объема применен в работе Пантелиса Калайцидакиса, Феофаниса Мамунеаса и Танасиса Стенгоса (Kalaitzidakis et al., 2003).

Разработка национальных индексов цитирования дала возможность проводить библиометрические оценки региональных журналов. Так, Российский индекс научного цитирования (РИНЦ) стал использоваться как инструмент для анализа российских НЭЖ.

В России первой попыткой классифицировать по научной значимости журналы по экономике и смежным дисциплинам на основе анализа библиометрических показателей стал авторский рейтинг, составленный Александром Муравьевым. Его особенность состоит в использовании 14 показателей, основанных на данных РИНЦ. Помимо стандартных критериев, в частности импакт–фактора, автор применил индикаторы, рассчитанные на базе списков литературы журнальных статей. Путем стандартизации и агрегирования все показатели были сведены в 5 обобщенных рангов. В результате были выделены 24 ведущих журнала по экономике и смежным дисциплинам, из которых 10 были отнесены к наиболее значимым изданиям условной категории «А»: Вопросы экономики, Форсайт, Российский журнал менеджмента, Журнал Новой экономической ассоциации, Экономическая политика, Экономический журнал Высшей школы экономики, Экономика и математические методы, Экономическая наука современной России, Прикладная эконометрика, Управление большими системами. Остальные получили статус журналов хорошего уровня и были причислены к категории «В» (Муравьев, 2013).

В ходе своего исследования Александр Муравьев сделал интересное наблюдение: ведущие 10 журналов по экономике не являются первыми 10 журналами по значению импакт–фактора. Данный обстоятельство свидетельствовало о несовершенстве импакт-фактора, рассчитываемого в РИНЦ в качестве меры научной значимости и качества журналов. Автор рейтинга пришел к выводу о непригодности имеющихся библиометрических инструментов оценки качества НЭЖ в России. Не считая свой методологический подход совершенным, А. Муравьев выразил надежду, что дальнейшие исследования могут уточнить и расширить перечень критериев, используемых для оценки журналов.

Рейтинги, фиксирующие ранжирование журналов экономических институтов РАН на основе библиометрических данных РИНЦ, представлены в работах Ольги Третьяковой (Третьякова, 2015; 2018). Ранжирование журналов осуществлено по методике многомерного сравнительного анализа, основанной на методе расстояний. Выделено ядро из 10 ведущих НЭЖ, аффилированных с организациями академического сектора. В версии рейтинга 2018 г. используется усовершенствованный состав критериев для анализа журналов, включающий оригинальный показатель, отражающий число высокоцитируемых статей. Введение этого индикатора дало возможность опираться в оценке качества журнала на характеристику его способности аккумулировать «прорывные» статьи. Верификация итоговых результатов с данными других рейтингов, близких по временному периоду, показала достаточно высокую корреляцию с версией 2016 г. гибридного Рейтинга ведущих экономических журналов России (Балацкий, Екимова, 2015), разработанного на основе учета библиометрических параметров и экспертной оценки.

Преимущество библиометрического подхода ранжирования НЭЖ заключается в широте охвата журнальных массивов и в нивелировании фактора субъективности, свойственного экспертным оценкам. Недостаток наукометрических показателей состоит в их уязвимости для манипулирования со стороны инсайдеров рынка; для России эта проблема усугубляется отсутствием авторитетной национальной базы научного цитирования, которая могла бы использоваться в качестве надежного источника для оценки качества НЭЖ.

4. Экспертные методы оценки качества НЭЖ

Параллельно с появлением журнальных рейтингов, основанных на библиометрических данных, большую популярность получили и ранжирования, основанные на экспертных оценках. Так, в 1973 г. вышла работа Роберта Хокинса, Лоуренса Риттера и Инго Уолтера, в которой авторы, используя метод Дельфи, в ходе двухэтапного опроса 160 экономистов проранжировали 87 американских НЭЖ (Hawkins et al., 1973). По словам авторов, цель данного исследования заключалась в том, чтобы консолидировать мнение экономистов о журналах, которое они обычно высказывают в кулуарных беседах, и определить пункты разногласия относительно того или иного журнала. В 1977 г. исследование Хокинса, Риттера и Уолтера было распространено Кеном Баттоном и Дэвидом Пирсом на 20 британских НЭЖ (Button, Pearce, 1977).

К более поздним работам относится исследование Жан–Луи Малуина и Жан-Франсуа Утревиля: авторы провели опрос 1045 экономистов из США, Великобритании, Франции и Канады, по результатам которого было отобрано 112 наиболее престижных международных НЭЖ (Malouin, Outreville, 1987). В 1993 г. Карл Эномото и Сумендра Гхош на основе опроса руководителей экономических факультетов американских университетов проранжировали 50 НЭЖ (Enomoto, Ghosh, 1993). В 2001 г. Самир Бармен, Марк Ханна и Лоуренс Лафорж обновили свое исследование 10–летней давности (Barman et al., 1991), ранжировав 21 журнал в области менеджмента на основе опроса 728 академических экспертов (Barman et al., 2001). В том же году Михаэль Браунингер и Юстус Хаукап провели опрос немецкоязычных экономистов относительно их взглядов на экономические издания и ранжировали порядка 150 журналов (Brauninger, Haucap, 2001). В 2011 г. авторы повторили свое исследование, которое показало, что за прошедшее десятилетие большая часть немецких журналов утратила свои позиции, уступив их англоязычным изданиям (Brauninger et al., 2011).

К относительно новым подходам к экспертному ранжированию журналов относятся исследования, основанные на методе «оценки активных ученых» (Active Scholar Assessment, ASA). Его суть заключается в том, что для построения рейтинга все так же используются данные веб-опросов часто публикующихся в ведущих журналах авторов, только теперь они не ранжируют журналы, как это было распространено на ранних этапах построения экспертных рейтингов, а дают оценки их качеству и важности по шкале Лайкерта [1], которые в последующем обрабатываются самими ранкерами. В результате журналы делятся на 4 группы (A, B, C, D), внутри которых могут выделяться различные подгруппы (например, А+, А и А–) (Currie, Pandher, 2011; 2020).

Еще один нетрадиционный подход, основанный не столько на опросе экспертов, сколько на их публикационных предпочтениях, был предложен Франсеско Пухолем (Pujol, 2008). Его идея заключается в том, что существует определенная группа журналов, которые постоянно занимают лидирующие позиции в рейтингах. Анализ публикационной активности авторов в данных журналах дает возможность определить пул высококлассных исследователей, публикуемость которых во всех остальных изданиях позволяет произвести ранжирование последних. Так, исследование публикационной активности в 8 ведущих американских изданиях (Econometrica, American Economic Review, Journal of Economic Literature, Economic Journal, Journal of Economic Theory, Quarterly Economic Journal, Journal of Political Economy, Review of Economic Studies) за 1990–2001 гг. позволило Пухолю отобрать 4681 исследователя, проанализировать 6102 их статей в 31 экономическом издании и составить рейтинг публичных НЭЖ (Pujol, 2008).

Первой заметной российской работой подобного рода явилась статья Сергея Аукуционека и Галины Чуркиной, в которой анализировалась динамика передовых экономических журналов (Аукуционек, Чуркина, 2002). Отличительная особенность данной работы состояла в том, что рейтингование осуществлялось тогда, когда в стране еще не появилась база данных РИНЦ, а рынок НЭЖ был крайне узким. Данные обстоятельства предопределили ранжирование изданий исключительно на экспертных оценках, равно как и упрощенность исследования.

Следующей значимой попыткой ранжирования НЭЖ России на основе опросов стал проект Высшей школы экономики (ВШЭ), реализованный в 2014–2015 годы [2], в котором приняли участие 630 исследователей, отобранных по результатам двухэтапных итераций. Изначально командой проекта по результатам анализа формальных индикаторов и внешних консультаций были определены эксперты верхнего уровня, которые в свою очередь должны были предложить не менее 25 кандидатур конечных респондентов. По экономике количество экспертов верхнего уровня составило 9 человек, которые на роль конечных экспертов отобрали 149 кандидатур. Непосредственно в анкетировании приняло участие 44 человека, проанализировавших 58 отечественных НЭЖ. Первоначально экспертам предлагалось отобрать издания, отвечающие двум условиям: журнал должен быть знаком эксперту и являться научным. По отобранным журналам эксперт заполнял анкету из 12 вопросов, обработка которой позволила сформировать три основные (А1 – высокий уровень, широкий профиль; А2 – высокий уровень, узкий профиль; В – средний уровень) и одну вспомогательную (С – журналы, отмеченные хотя бы одним экспертом как научные) группы. По направлению «Экономика» 2 журнала были отнесены к группе А2 (Форсайт, Экономический журнал ВШЭ) и 17 изданий – к группе В.

Одной из самых масштабных работ по экспертному рейтингованию российских НЭЖ является исследование Александра Рубинштейна и его коллег (Рубинштейн и др., 2017). Рейтинг основан на социологических опросах членов Новой экономической ассоциации (НЭА) (Рубинштейн, 2011, 2014, 2018). В исследовании, проведенном в 2017 г., приняло участие 1059 респондентов, которые дали свою оценку российским НЭЖ. Обработав экспертную информацию, группа разработчиков составила частные рейтинги журналов, присвоив им соответствующие весовые коэффициенты, распределила группу экспертов по трем сегментам (преподаватели вузов, сотрудники академических институтов, эксперты-аналитики), выделив в них подгруппу «продвинутых специалистов» (Advanced), и на основе оценок данной подгруппы и соответствующей весовой функции ранжировала 26 журналов, распределив их на пять категорий: А1, А2, А3, В1 и В2 (Рубинштейн, 2018). По мнению авторов исследования, экспертный подход позволил устранить недостатки использования библиометрической информации и измерить «интуитивные представления экономистов о научном авторитете журналов, формирующие мнение экспертного сообщества, которые вряд ли целесообразно замещать формальными показателями» (Рубинштейн, 2018, с. 109). После 2017 г. группа Рубинштейна продолжила проект рейтингования и в 2018–2019 гг. был проведен опрос около 600 экспертов, а в 2020 г. – почти 1200, что позволяет рассчитывать на появление новой волны рейтинга.

Тем не менее, ранжирование, основанное на экспертном подходе, достаточно часто подвергаются критическим замечаниям. Среди их основных недостатков выделяются высокая трудоемкость и субъективность (Thelwall, 2017; Serenko, Bontis, 2018; Dondio et al., 2019). В частности, исследование Рубинштейна грешит и первым, и вторым. Так, результаты достаточно сложных и масштабных вычислений весовых коэффициентов практически не отличаются от их простого усреднения (Рубинштейн и др., 2017, с. 22), а вопросы анкеты характеризуются явной избыточностью (Рубинштейн и др., 2017, с. 64). Кроме того, рейтинг Рубинштейна не проходит общий для всех рейтингов тест на нейтральность: разработчиками изначально на обсуждение был вынесен ограниченный список изданий, сформированный на основе субъективных оценок посредством выделения 13 журналов из списка RSCI и добавления к ним еще 13, «при выборе которых нашли отражение рекомендации «целесообразно рассмотреть»» (Рубинштейн, 2018, с. 111). При этом в список не попал, например, журнал Terra Economicus, который на сегодняшний день является одним из немногих, входящих в квартиль Q1 базы данных Scopus, тогда как в итоговом списке в передовой группе фигурирует Журнал НЭА, главным редактором которого является разработчик рейтинга – А. Рубинштейн.

Для решения проблемы субъективности экспертных оценок в последние годы начинают разрабатываться технологии, основанные на новых достижениях машинного обучения, позволяющие автоматизировать экспертные оценки и снижать зависимость результатов от интуитивных суждений (Saarela, Karkkainen, 2020). Кроме того, внедряются новые подходы, о которых речь пойдет ниже.

Сильной стороной опросного метода выступает тот факт, что эксперты фокусируют свое внимание на содержании материалов журнала, а не производных библиометрических показателях, которые зачастую никак не связаны с глубиной, оригинальностью и уровнем публикуемых материалов. Слабая же сторона экспертного метода состоит, как уже отмечалось, в его трудоемкости и невозможности устранения субъективности оценок. Последние связаны не столько со злонамеренностью и ангажированностью экспертов, сколько с их принадлежностью к определенной научной группе с присущими ее членам специфическими традициями, симпатиями и антипатиям в отношении тематики, методов, идеологии и презентации исследований.

5. Сетевые подходы и алгоритмы рейтингования НЭЖ

Еще одним методом анализа и оценки уровня научных журналов является сетевой подход, который представляет собой следствие широкой цифровизации научного пространства и позволяет учитывать не только количество журнальных цитат, но вес и значимость цитирующего издания. Несмотря на то, что идея изучения библиографических данных посредством сетей принадлежит одному из основоположников наукометрии Дереку де Солла Прайсу и возникла она еще в 1965 г. (De Solla Price, 1965), ее воплощение стало возможно только в XXI веке – в эпоху стремительного развития информационных технологий и массовой оцифровки документов.

В общем виде библиографические сети представляют собой граф, где некий исходный набор данных (автор, статья, журнал и т.п.) выступают в роли вершин (узлов), а ссылки, цитирования и другая подобного рода информация определяет связи (ребра) между вершинами (узлами) (Radicchi et al., 2012). Наиболее часто в библиометрическом анализе изучаются три вида сетей цитирования: авторов, статей и журналов. Последние – это граф, в котором журналы рассматриваются в качестве узлов, а ребра содержат информацию о количестве цитирований одним изданием другого (Milojevic, 2014).

Одна из ключевых задач анализа сетей цитирования заключается в том, чтобы определить наиболее важные узлы и связи. В общем случае для решения данной задачи используют наиболее простые и известные методы подсчета и агрегирования, такие как журнальный импакт–фактор или H-индекс. Однако они, как правило, не позволяют учесть «важность» цитирующего издания, уравнивая значимость высокоцитируемых журналов с неизвестными и малоцитируемыми. Решают указанную проблему методы, основанные на алгоритме PageRank (Waltman, Yan, 2014), первая версия которого была разработана в 1998 г. основателями поисковой системы Google Сергеем Брином и Ларри Пейджем для ранжирования веб–страниц. Идея метода заключается в том, что рейтинг страницы увеличивается по мере роста ссылок на нее, особенно со страниц, которые сами обладают высоким рангом и значимостью (Brin, Page, 1998; Page et al., 1999). Впоследствии данный подход был успешно применен при построении сетей цитирования журналов, статей и авторов (Bollen et al., 2006; Ding et al., 2009; Życzkowski, 2010; Ding, 2011).

Стоит отметить, что возможности учета значимости цитирующего элемента при анализе цитирований изучались еще задолго до внедрения метода PageRang. Так, например, еще в 1976 г. была опубликована работа Габриэля Пински и Фрэнсиса Нарина, в которой авторами была разработана методика определения «мер влияния», учитывающая вес и значимость цитирований каждого журнала (Pinki, Narin, 1976). Указанная разработка изначально была апробирована на журналах по физике, чуть позже она была применена к журналам по химии (Pinski, 1977) и другим дисциплинам (Narin, 1976). Предложенная методика была уточнена и конкретизирована в работах (Geller, 1978; Todorov, 1984); аналогичная идея «взвешивания» цитат содержалась и в работах Патрика Дореяна (Doreian, 1985; Doreian, 1987). Подробный обзор истоков метода PageRank приводится в работе (Franceschet, 2011).

Широкое распространение в библиометрическом анализе сетевой подход получил только после создания PageRank, использование которого позволило создать ряд новых методов, усовершенствовавших работу с сетями цитирования журналов (Waltman, Yan, 2014). Так, Йохан Боллен, Марко Родригез и Герберт Ван де Сомпель внесли поправку на размер журнала и использовали коэффициент демпфирования, предполагающий постепенное «затухание» цепочки последовательных цитирований (Bollen et al., 2006). Клас Бергстром разработал метод собственных факторов (Eigenfactor method), согласно которому каждому журналу присваивается два параметра, зависящих от его размера: значение собственного фактора и значение влияния статьи на журнал (Bergstrom, 2007). В настоящее время данный подход активно используется компанией Thomson Reuters при анализе цитирований журналов.

Еще одна разработка на основе PageRank – метод SCImago Journal Rank (SJR), в котором на вес цитирования влияет не только «престижность» журнала, но и тематическая близость между цитируемым и цитирующим журналами (González-Pereir et al., 2010; Guerrero-Bote et al., 2012). Данный метод используется компанией Elsevier для определения квартилей журналов базы данных Scopus, ставшей одной из самых популярных в России.

Отечественная практика исследования сетей цитирования наиболее ярко представлена работами сотрудников Института вычислительной математики и математической геофизики СО РАН Сергея Бредихина, Виктора Ляпунова и Натальи Щербаковой, в которых авторами на основе данных международной библиографической базы RePec была изучена структура сети цитирования НЭЖ и определены наиболее значимые для анализа показатели (Бредихин и др., 2017а), а также проведен кластерный (Бредихин и др., 2017б) и спектральный (Бредихин и др., 2018; Бредихин и др., 2019) анализ сети цитирования изданий базы.

Другой наиболее значимой работой по использованию сетевого подхода для НЭЖ является исследование группы ученых из ВШЭ под руководством Фуада Алескерова (Алескеров и др., 2016). Построенный рейтинг ведущих российских и международных экономических журналов основан на методе анализа перекрестного цитирования с учетом не только индексов центральности, но и индексов ближних и дальних взаимодействий в сетях, что является отличительной особенностью авторской методики ранжирования от классического подхода (Leydesdorff, 2007; Zhang et al., 2009). Так, анализ цитирований 29 российских НЭЖ, отобранных экспертами из базы данных РИНЦ за период 2011–2016 гг., позволил выявить системно значимые журналы, к числу которых относятся Вопросы экономики, ЭКО, Экономическая политика, Деньги и кредит, Журнал НЭА и др. (Алескеров и др., 2016). Полученные результаты, с одной стороны, упрощают задачу исследователей при выборе издания для публикации, отсеивая журналы низкого качества и задавая ориентиры на высокоцитируемые издания, с другой – они обладают целым рядом недостатков, которые еще больше запутывают их в этом выборе. В частности, рейтинг однозначно не отвечает на вопрос о качестве журнала, поскольку не имеет итогового балла, а оценки по расчетным индексам дают различные, зачастую противоречивые результаты. Например, журнал Деньги и кредит по классическим индексам центральности (PageRank) занимает только 20 место, тогда как по индексам дальних и ближних взаимодействий находится в числе лидеров; аналогичная ситуация наблюдается и в отношении Журнала НЭА (Алескеров и др., 2016). Противоположную картину можно наблюдать в отношении журналов Инновации и Terra Economicus, которые, являясь лидерами по классическим индексам, замыкали ранжирование по авторским индексам дальних и ближних взаимодействий. Кроме того, по отдельным журналам имеются слишком явные расхождения в отношении оценки их значимости с другими рейтингами. Так, один из лидеров рассматриваемого рейтинга, журнал ЭКО, по оценкам других ранкеров занимает места от 2 до 48 (Субочев, 2016). Очевидно, что данный факт не позволяет делать однозначные выводы о качестве данного журнала.

Таким образом, в основе сетевого подхода лежит специфический математический аппарат, который, с одной стороны, позволяет формализовать процесс рейтингования журналов и получить достаточно точные результаты, с другой – усложняет процедуру и снижает достоверность итогового рейтинга за счет целого ряда априорных ограничений и допущений. Кроме того, данный подход также не лишен субъективности. Например, в рассматриваемом выше рейтинге в качестве исходных данных из 192 российских НЭЖ, представленных к 2016 г. в РИНЦ, анализировалось только 29 изданий, что изначально оставило за рамками изучения более полутора сотен изданий (Алескеров и др., 2016).

Можно отметить, что в рамках сетевых методов апробируются оригинальные подходы, связанные с исследованием таксономии предметной области, т.е. иерархии ее понятий для вычисления уровня результативности, например, исследователя или журнала, оцениваемого в соответствии с рангами тех понятий таксономии, которые возникли или были существенно преобразованы благодаря этим результатам (Mirkin, Orlov, 2014). Однако это лингвистическое направление для изучения рынка НЭЖ пока не используется.

В целом сетевому методу присущи те же недостатки и преимущества, как и библиометрическому подходу. Важный плюс сетевого метода состоит в исследовании всей «географии» научного поля НЭЖ, когда наряду с выявлением центра влияния (зоны «сгущения» цитирований передовых изданий) определяется и обширность зоны его влияния («дальность» центра от периферии цитирующих его журналов). Минус же сетевого метода состоит в том, что объединение «центральных» и «периферийных» оценок рынка НЭЖ в единый параметр так и не осуществлен [3].

6. Гибридные рейтинги НЭЖ

Развернувшееся движение по ранжированию НЭЖ породило и волну их критики, связанную, в первую очередь, с выбором показателей и нерепрезентативностью экспертных групп (Serenko, Bontis, 2013; Рубинштейн, 2016). С целью устранения данного недостатка стали осуществляться попытки «компенсации» недостатков имеющихся рейтинговых продуктов за счет построения гибридных и консолидированных рейтингов.

Гибридные рейтинги совмещают в себе экспертные (субъективные), основанные на экспертных оценках, и библиометрические (объективные), опирающиеся на количественные показатели, подходы. В зарубежной практике данный подход получил широкое распространение в начале нынешнего века. Так, в 2001 г. сотрудниками Вашингтонского университета (University of Washington) совместно с коллегами из Городского университета Гонконга (City University of Hong Kong) был разработан комплексный подход к оценке журналов, интегрирующий в себе субъективную и объективную информацию, апробация которого показала его предпочтительность для участников рынка по сравнению с традиционными рейтинговыми исследованиями (Zhou et al., 2001).

Несколько позже Рональд Бауэрли и Дон Джонсон оценили качество НЭЖ по частоте цитирований в учебных программах в докторантуре. Объединив субъективный (опросы экспертов) и объективный (анализ цитируемости) подходы, авторы составили базу данных, включающую 6294 цитаты из 3423 журналов, использовавшихся в 109 докторских программах по маркетингу, после чего осуществили ранжирование изданий и показали, что 66,5% цитирований приходится на первую пятерку лидеров (Bauerly, Johnson, 2005).

Одной из наиболее полномасштабных работ по использованию гибридного подхода при ранжировании журналов является исследование коллектива из Национального университета Тайваня (National Taiwan University) (Kao et al., 2008). Авторами была произведена оценка 46 журналов по управлению на основе опроса 345 экспертов и четырех количественных показателей (перекрестное цитирование журналов, цитирование в диссертациях, научная репутация авторов, разнообразие авторов), их ранжирование и классификация по пяти группам (A, B, C, D, E). Полученные результаты совпали с ожиданиями ученых и были высоко оценены представителями оцениваемых журналов (Kao et al., 2008).

Гибридным является и рейтинг академических журналов Ассоциации бизнес-школ Великобритании (The Association of Business Schools, ABS), один из самых влиятельных рейтингов, который раз в три года предоставляет оценку почти полутора тысяч изданий в области бизнеса и менеджмента, определяя среди них «мировую элиту» (группа 4*), журналы, публикующие самые оригинальные и высокоуровневые исследования (группа 4), оригинальные и хорошо выполненные исследования (группа 3), исследования стандартного качества (группа 2) и исследования «скромного» качества (группа 1) (ABS, 2018).

Российская практика использования гибридных подходов представлена в работах (Балацкий, Екимова, 2015; 2017). Разработанный авторами рейтинг представляет собой многоступенчатую процедуру отбора лучших российских экономических изданий, основанную на сочетании библиометрических и экспертных оценок. Количественные оценки включают в себя показатели базы данных РИНЦ (общее число цитирований журнала без самоцитирования; 5–летний импакт–фактор журнала без самоцитирования; 5–летний индекс Херфиндаля–Хиршмана журнала по цитирующим журналам; время полужизни статей журнала, процитированных в текущем году), а также коэффициент потенциала высоких цитирований, характеризующий способность журнала публиковать прорывные результаты исследований (Третьякова, 2015). Формируемая в результате анализа и ранжирования объективных показателей выборка из 100 российских НЭЖ подвергается дальнейшей обработке группой экспертов, оценивающих научный уровень издания с учетом его международного статуса. Окончательный массив рейтинга представлен 50 лучшими НЭЖ России.

Еще один оригинальный тип гибридного рейтинга НЭЖ представлен в работе (Рубинштейн, Слуцкин, 2018), который основан на сборе экспертной информации с помощью опросов, а обработка собранных данных осуществляется с помощью итеративного алгоритма с использованием метода «Multiway data analysis». Построенный алгоритм имеет прозрачную геометрическую интерпретацию и позволяет определить ядро журналов с учетом не только оценок экспертов, но и характеристик самих экспертов и их связей с НЭЖ. Таким образом, метод Рубинштейна–Слуцкина представляет собой редко встречающуюся смесь экспертных и сетевых подходов.

Нет сомнений, что гибридные рейтинги позволяют хотя бы отчасти примирить формализм библиометрических методов и волюнтаризм экспертных, однако полностью решить проблему оценки качества НЭЖ они все равно не могут. В идеале грамотно составленные и взвешенные составляющие гибридного рейтинга – библиометрическая и экспертная – должны нивелировать разнонаправленные недостатки друг друга, однако всегда остается довольно большой риск того, что недостатки обоих методов на практике окажутся однонаправленными и, вопреки ожиданиям, наоборот, усилят общую ошибку при оценивании НЭЖ.

7. Консолидированные рейтинги НЭЖ

Идея обобщения существующих рейтингов академических журналов в мировой практике не является новой. Первые попытки агрегирования рейтингов относятся к 1975 г., когда профессором Массачусетского университета Лоуэлла (University of Massachusetts Lowell) Кэрол Макдоно был проведен корреляционный анализ пяти рейтингов американских НЭЖ по пяти критериям (цитирование, институциональная принадлежность авторов, оценки читателей и экспертов, частота появления ссылок на статьи из журнала в списках литературы выпускных работ) и построен обобщенный рейтинг 70 изданий (McDonough, 1975).

Келли Райнер и Марк Миллер продолжили начатую традицию, усреднив девять журнальных рейтингов, опубликованных в период 1991–2003 гг., и составив сводный Топ–50 лучших журналов, показав, что композитный рейтинг заметно сглаживает разницу между различными подходами к ранжированию (Rainer, Miller, 2005). Штефан Теуссл и Курт Хорник исследовали возможность построения консенсусных рейтингов путем решения задач оптимизации (Theussl, Hornik, 2009). Джордж Халкос и Николас Церемес с помощью анализа среды функционирования (Data Envelopment Analysis, DEA) оценили эффективность 229 НЭЖ, ориентируясь на показатели четырех баз данных (Scopus, RePEc, SSCI, Econlit) и двух рейтингов (KIEL internal ranking, ABS Academic Journal Quality Guide), и классифицировали их по четырем категориям (A, B, C, D) в зависимости от полученного уровня эффективности (Halkos, Tzeremes, 2011).

Еще одним примером агрегирования рейтинговых продуктов является исследование Виктора Клаара и Рута Гонзалеза, в котором авторы провели обобщение трех журнальных рейтингов, основанных на количественных показателях (Laband, Piette, 1994; Kalaitzidakis et al., 2003; Kodrzycki, Yu, 2006), и двух рейтингов, построенных по данным экспертных опросов (Mason et al., 1997; Axarloglou, Theoharakis, 2003), в результате чего была получена и ранжирована агрегированная база данных, включающая 284 НЭЖ (Claar, Gonzalez, 2014).

К более поздним работам относится агрегированный рейтинг, предложенный Чиа–Линь Чанг, Эсфандияром Маасуми и Майклом Макалиром, в котором 229 НЭЖ анализировались по 15 показателям из базы данных Web of Science (WoS) и частных рейтингов (Chang et al., 2016). В последующем данная работа была продолжена Клаусом Вольрабе, ранжировавшим 315 НЭЖ по 38 показателям (Wohlrabe, 2016), и Лутцом Борнманном, Александром Буцом и Клаусом Вольрабе, сконструировавшими мета–рейтинг 277 изданий по экономике на основе 22 различных рейтингов (Bornmann et al., 2017). Используемый подход позволил учесть характеристики цитирования журналов в разных библиометрических базах (Google Scholar, Web of Knowledge и RePEc), а также совместить количественные и качественные оценки изданий.

Агрегирование частных рейтингов получило широкое распространение не только при ранжировании НЭЖ, но и в других областях. Так, Уэйд Кук, Тал Равив и Алан Ричардсон построили консенсусный рейтинг для журналов по бухгалтерии, обобщив с помощью метода ветвей и границ 26 частных рейтингов (Cook et al., 2010). С использование метода DEA были построены агрегированные рейтинги журналов в области операционного менеджмента в работах Тимоти Фрая и Джоан Донахью, обобщивших 15 более ранних исследований по ранжированию (Fry, Donohue, 2013), и команды Хайнца Тюсельманна, рассмотревшей 939 журналов из 11 рейтингов (Tuselmann et al., 2015). Комплексный анализ 11 рейтингов журналов по маркетингу был проведен Мишелем Стюардом и Брюсом Льюисом (Steward, Lewis, 2010). Подход, предложенный в работе (Theussl, Hornik, 2009), в последующем был апробирован авторами при построении консенсусного рейтинга 62 журналов по маркетингу, которые вошли в 12 популярных частных рейтингов (Theussl et al., 2014). Подробный обзор мета–ранжирований журналов приведен в (Theussl et al., 2014; Tuselmann et al., 2015).

Российские исследователи не остались в стороне от указанного направления исследований: в числе первых работ по консолидации рейтинговых систем находится серия исследований (Алескеров и др., 2011; Алескеров и др., 2013; Aleskerov et al., 2014), в которых на основе агрегирования ранговой информации по отдельным показателям дается оценка международным академическим журналам по менеджменту, экономике и политологии. Для построения агрегированных оценок использовались ординальные методы теории коллективного выбора (Arrow, 1951), позволяющие решить проблему несопоставимости количественных оценок в разных рейтингах.

Другой консолидированный рейтинг журналов по экономике и смежным дисциплинам был составлен Александром Муравьевым на основе сравнения и обобщения наукометрического рейтинга Муравьева, экспертного рейтинга Стерлигова и гибридного рейтинга Балацкого–Екимовой. Анализ Топ–24, Топ–25 и Топ–35 журналов из указанных трех рейтингов позволил отобрать 22 ведущих издания, которые вошли по меньшей мере в два из трех анализируемых рейтингов, и ранжировать их (Муравьев, 2015).

Дальнейшее развитие указанного направления связано с исследованием Андрея Субочева, в котором с помощью коэффициента Кендалла был проведен корреляционный анализ рейтингов Стерлигова, Муравьева и Балацкого–Екимовой друг с другом, а также с тремя системами ранжирования базы РИНЦ (2–годовым и 5–летним импакт–фактором и параметром Science Index). Расчеты показали слабую сопоставимость трех авторских рейтингов как между собой, так и с рейтингами РИНЦ. Для устранения полученного рассогласования автором был построен агрегированный рейтинг, который представил совокупность трех исходных рейтингов лучше, чем любой из них в отдельности (Субочев, 2016).

Еще один консолидированный продукт, объединивший четыре авторских рейтинга (Муравьева, Балацкого–Екимовой, Стерлигова и Рубинштейна), предложен в работе (Балацкий, Екимова, 2018а). Построенный консенсусный рейтинг позволил сформировать список лучших российских НЭЖ, показавший, что действительный консенсус среди разработчиков рейтингов достигается только в отношении очень ограниченного круга изданий (порядка 15), за пределами которого согласованность оценок резко падает.

Безусловно, построение консолидированных рейтингов, позволяющих в той или иной степени задействовать закон больших чисел, позволяет подавить ошибки частных рейтинговых продуктов и повысить объективность искомой оценки НЭЖ. Однако и этот метод имеет свои недостатки и ограничения. Первая проблема состоит в необходимости временной синхронизации рейтинговых оценок. В идеале при консолидации рейтингов они все должны быть составлены на одну дату, однако в связи с тем, что построение рейтинга является трудоемкой, длительной и дорогостоящей процедурой, многие из них составляются не ежегодно, а периодически – раз в 3 или 5 лет. Рассогласование дат составления рейтингов может давать сильные искажения, прежде всего, для молодых и динамичных рынков, к каковым относится рынок российских НЭЖ. Вторая проблема связана с консолидацией разнотипных (количественных и качественных) рейтингов и их взаимной конверсией. Например, перевести строго ранжированный перечень из 100 журналов в список 100 изданий, состоящий из четырех качественно различных групп по 25 журналов в каждой, и обратно, однозначным образом невозможно. Если же исходные списки разной величины, а включенные в них журналы не совпадают, то это сделать еще сложнее. Таким образом, при составлении консолидированных рейтингов довольно высока вероятность того, что объективные различия между НЭЖ будут нивелироваться.

8. Институциональные фильтры

Институциональные фильтры, устанавливаемые на НЭЖ по инициативе государства и использующиеся ведомствами для оценки научной результативности организаций и научных коллективов, основываются на разнообразных рыночных аналитических инструментах оценки качества изданий, рассмотренных выше. Совокупность таковых определяет научную политику государства. Подобная регулятивная практика в XXI веке охватила многие страны мира.

Так, большинство стран Европейского союза (ЕС) перешли на системы финансирования науки, основанные на учете результативности деятельности научных организаций (Гусев и др., 2018). Для этого во многих странах ЕС введена система эффективных контрактов между организациями и министерством–учредителем, которая предусматривает выполнение научной организацией обязательных целевых показателей научной результативности, среди которых используются различные библиометрические индикаторы, например, число публикаций и импакт-фактор журнала. В Великобритании, например, библиографические параметры, используемые экспертным советом для оценки эффективности научных учреждений, носят справочный характер, а их число минимально. В Венгрии, наоборот, Венгерский комитет по аккредитации контролирует процесс продвижения ученых от доцента до профессора. При оценке учитываются статьи, опубликованные в журналах, входящих в список Венгерской академии наук (ВАН), включающий издания четырех категорий. Примечательно, что ВАН пыталась заменить данный список журналами, индексируемыми в базе WoS, но эти попытки не увенчались успехом; с 2015 г. основным источником для обновления перечня стала база данных Scopus (Grančay et al., 2017).

Похожую политику проводит Министерство науки и высшего образования Польши, которое составляет список рекомендованных авторам научных журналов, в который входит около 20 тыс. изданий, входящих в поисковую систему ICI World of Journals. Все журналы разделены на три категории для дифференциации начисляемых за публикации баллов и используются при оценке ученых и университетов Польши. Согласно установленным требованиям, каждый исследователь должен представить не менее 4 статей, опубликованных в течение оцениваемого периода (4 года) в научных журналах, входящих в министерский список, в котором присутствуют и российские НЭЖ. Например, в перечень включен журнал Вологодского научного центра РАН «Проблемы развития территории». В 2020 г. редакция журнала получила письмо из Польши, в котором сообщалось, что за каждую публикацию в данном издании польским ученым будет начисляться 20 баллов за научные достижения.

С усилением роли МНБД изменились системы аккредитации европейских университетов. Например, в Словакии до 2013 г. для получения звания доцента или профессора не фигурировали требования по числу публикаций в журналах МНБД; в новых правилах аккредитации был сделан акцент на учет публикаций в ведущих изданиях, включенных в базы WoS и Scopus. В результате подобной институциональной инновации словацким университетам пришлось модернизировать свои академические системы продвижения по службе и устанавливать требования к публикациям в высокорейтинговых журналах (Grančay et al., 2017).

Даже в США научная политика подчиняется закону «Об оценке результатов деятельности государственных учреждений» (Government Performance and Results Act), который предусматривает отчеты по итогам реализации государственных программ и оценку их эффективности, в том числе на основе широкого спектра библиометрических показателей (Гусев и др., 2018).

Однако, пожалуй, наибольшего развития новая система получила в Китае, где координационные функции в реализации научной политики осуществляют Министерство науки и техники, Академия наук Китая, ведущие ведомства и университеты страны (Виноградов и др., 2016). Одним из основных показателей, используемых в последнее время для оценки исследователей, распределения финансирования и ранжирования учреждений, являются показатели основного журнального индекса базы WoS – SCIE. Результат подобной политики весьма впечатляет: число статей китайских авторов в журналах, индексируемых в SCIE, увеличилось со 120 тыс. в 2009 г. до 450 тыс. в 2019 г. (Mallapaty, 2020). Пинг Чжоу и Лоэт Лейдесдорф подтверждают, что сложившаяся система финансирования и вознаграждения китайских ученых основана на учете публикаций в журналах базы WoS (Zhou, Leydersdorff, 2016). Так, Министерство науки и технологий Китая в рамках Национального плана развития науки и технологии оценивает международный академический статус опубликованных исследований с помощью библиометрических инструментов: индекса научного цитирования SCIE, системы Journal Citation Reports, т.е. учитывается индексация журнала в основном индексе цитирования базы WoS, импакт-фактор журнала и его положение в квартиле.

В русле новой научной политики Китай провел ряд масштабных инициатив. Например, для повышения статуса и авторитета китайских ученых, исследовательских проектов и научных журналов, в ноябре 2013 г. был реализован План повышения уровня цитируемости при поддержке национальных научных агентств и фондов, Китайской академии наук и целого ряда министерств. В результате этого проекта 76 китайских журналов, индексируемых в SCIE, получили финансовую поддержку, размер которой широко варьировался в зависимости от рейтинга издания (Zhou, Leydersdorff, 2016). Для стимулирования научной продуктивности своих исследователей китайские университеты широко используют систему денежного вознаграждения за публикации. Так, размер разовой денежной выплаты за статью в высокорейтинговом журнале WoS может быть равен годовой зарплате начинающего профессора, а вознаграждение за статью, опубликованную в журнале «Nature» или «Science», в 20 раз превышать ее величину, которая несколько лет назад составляла 8,6 тыс. долл. США (Quan et al., 2017).

Важной особенностью китайской научной политики является ее американоцентричность: премирование университетами страны осуществлялось только за статьи в американской базе WoS, тогда как публикации в европейской базе Scopus игнорируются. При этом с 2008 г. многие вузы увеличили размер денежного вознаграждения за статьи в журналах ранга Q1 и Q2 базы WoS и снизили или совсем прекратили поощрительные выплаты за статьи в журналах ранга Q3 и Q4 (Quan et al., 2017).

Результаты подобной политики неоднозначны. С одной стороны, Китай занял верхние позиции по научной продуктивности среди мировых научных лидеров, включая США и передовые страны ЕС. С другой стороны, в вузах страны идет снижение качества преподавания из-за избыточной ориентации исследователей на создание своего публикационного портфолио (Shu et al., 2020); возник всплеск академических нарушений со стороны китайских исследователей (Teixeira da Silva, 2017), появилась практика публикации плагиата и фальсификации исследований; идет активное манипулирование цитированием (Tang et al., 2015). В связи с этим с февраля 2020 г. в Китае проводится новая научная политика, ориентированная на отказ от чрезмерного употребления библиометрических показателей (Mallapaty, 2020).

Россия является региональным эпицентром использования институциональных фильтров для НЭЖ, среди которых можно выделить механизмы двух типов. К первому относятся те, которые основаны на «внутренних» (отечественных) источниках информации, ко второму – те, которые опираются на «внешние», т.е. МНБД.

Примером институционального фильтра первого типа является Перечень рецензируемых научных изданий (далее – Перечень ВАК), в которых должны быть опубликованы основные научные результаты диссертаций на соискание ученой степени кандидата и доктора наук. Он формируется Министерством науки и образования РФ на основании рекомендаций Высшей аттестационной комиссии (ВАК) в соответствии с определенными правилами [4]. Согласно установленным требованиям научные журналы, претендующие на включение в Перечень ВАК, должны подтвердить периодичность и регулярность выпуска, регистрацию в качестве СМИ, отправку обязательных экземпляров, научный характер основного содержания (научные статьи, обзоры и рецензии), наличие института рецензирования, корректность и полноту метаданных публикуемых статей. Научная квалификация членов редакционной коллегии регламентируется требованием к наличию в ее составе не менее трёх докторов наук, внесших значительный вклад в развитие соответствующей области знаний. Кроме того, издания должны иметь официальный сайт и регистрацию в РИНЦ [5]. Состав указанных требований позволяет отнести их к разряду экспертных, однако библиометрические данные (пятилетний импакт–фактора и т.п.) также учитываются при рассмотрении НЭЖ в экспертных советах ВАК.

По состоянию на 27.01.2021 в Перечень ВАК включены 2558 журналов [6]. Дополнительный список представлен 1079 изданиями, которые входят в международные реферативные базы данных и системы цитирования и считаются включенными в Перечень (по состоянию на 31.12.2020 г.) [7]. Из 1374 изданий, индексируемых в РИНЦ по тематике «Экономика. Экономические науки», 283 журнала включены в Перечень ВАК (по данным НЭБ на 10.02.2021), т.е. около 20% их общего массива. Значительный размер Перечня ВАК обусловлен несовершенством критериев качественной оценки изданий. Доказательством тому служит тот факт, что удельный вес низко- и нецитируемых НЭЖ, оказавшихся в Перечне ВАК в 2015 г., составил более 50% (Третьякова, 2016). Таким образом, Перечень ВАК продолжает действовать, но не гарантирует высокого качества включенных в него журналов и не воспринимается научным сообществом в качестве индикатора статуса журнала. По этой причине в 2016 г. Совет по науке при Министерстве образования и науки РФ выступил с инициативой провести постепенную замену Перечня ВАК на список журналов Russian Science Citation Index (RSCI) [8]. Данное решение во многом было связано с усилившейся ролью МНБД, которые продуцировали механизмы оценки НЭЖ нового типа.

Интерес российского регулятора к наукометрическим инструментам обусловил появление системы РИНЦ, запущенной в 2005 г. Научной электронной библиотекой при финансовой поддержке Министерства образования и науки РФ. Основой системы стала библиографическая база данных, индексирующая российские научные журналы, в том числе НЭЖ. Однако система РИНЦ довольно быстро подверглась массовому манипулированию данными, что искажало истинные оценки НЭЖ. В связи с этим параметры РИНЦ применяются для оценки деятельности научных организаций [9], но не используются в качестве целевых показателей в стратегических государственных документах РФ.

Попытки устранения недостатков базы РИНЦ привели к созданию в 2015 г. базы RSCI, включающей наиболее значимые российские журналы. Процедура отбора журналов в RSCI–2015, основанная на применении библиометрического метода и экспертизы, получила в экспертной среде неоднозначные оценки ввиду неравномерной представленности научной периодики с позиций библиометрических показателей и распределения журналов по тематическим рубрикам, а также непрозрачности критериев отбора (Мазов и др., 2018). Во второй редакции списка – RSCI-2018 – эти недостатки устранить не удалось: среди 28 НЭЖ из списка RSCI–2018 несколько изданий с невысокими библиометрическими показателями были оценены экспертами как журналы среднего уровня, а также журналы локальные, не соответствующие международным стандартам и базовым требованиям индекса (Третьякова, 2020). Слабые стороны списка RSCI определяются недостаточностью параметров и непоследовательностью в соблюдении установленных критериев отбора изданий. Тем не менее, издания из перечня RSCI–2018 вместе с журналами, индексируемыми в МНБД, включены в информационную подсистему Ядро РИНЦ, показатели которой учитываются в мониторинге результативности научных институтов и центров.

Что касается библиометрических параметров, основанных на МНБД, то они широко используются российским регулятором в качестве целевых ориентиров государственной научной политики (см. таблицу 1), начиная с «майских» указов 2012 г. Президента РФ, в которых была поставлена задача по повышению к 2015 г. доли работ российских исследователей в общем количестве публикаций, индексируемых в базе данных WoS, до 2,44% [10]. Согласно расчетам, фактическая доля российских публикаций в журналах WoS в 2015 г. составила 2,48% (Мосичева и др., 2018). В связи с тем, что целевой показатель был выполнен, в дальнейшем он был снят с учета (Гришакина, 2018).

Таблица 1

Сводные данные о документах, регламентирующих применение целевых индикаторов МНБД в России

|

Документ |

Целевые показатели (значение показателя) и индикаторы оценки научных организаций, основанные на данных МНБД |

|

О мерах по реализации государственной политики в области образования и науки: указ Президента РФ №599 от 07.05. 2012. |

Доля публикаций российских исследователей в общем количестве публикаций в мировых научных журналах, индексируемых в базе WoS (2,44%) |

|

Состав сведений о результатах деятельности научных организаций, выполняющих НИОКР гражданского назначения, представляемых в целях мониторинга и оценки: приказ Министерства образования и науки РФ № 162. Приложение 3 от 5.03. 2014. |

1) Число публикаций организации, индексируемых в WoS. |

|

Национальный проект «Наука»: паспорт национального проекта, протокол Совета при Президенте РФ по стратегическому развитию и национальным проектам №16 от 24.12.2018. |

1) Место Российской Федерации по удельному весу в общем числе статей в областях, определяемых приоритетами научно–технологического развития, в изданиях, индексируемых МНБД. |

|

Методика расчета качественного показателя государственного задания «Комплексный балл публикационной результативности» (КПБР) для научных организаций, подведомственных Минобрнауки России: утв. 25.08.2020. |

Коэффициент качества («научного уровня») статьи / журнала |

|

Программа фундаментальных научных исследований в Российской Федерации на долгосрочный период (2021–2030 годы): распоряжение Правительства РФ №3684-р от 31. 12. 2020. |

1) Удельный вес в общем числе статей в областях, определяемых приоритетами НТР, в изданиях, индексируемых в Web of Science Core Collection (70%) и Scopus (67%). |

Если первоначально институциональные фильтры, использующие инструментарий МНБД, основывались на учете количественных показателей, то к настоящему моменту приоритеты российского регулятора сместились в сторону использования качественных результатов. Так, среди целевых показателей Национального проекта «Наука» заявлено число статей в журналах первого (Q1) и второго (Q2) квартилей, индексируемых в базах WoS и Scopus, и численность ученых, опубликовавшихся в указанных журналах [11]. На обеспечение повышения качества публикаций российских ученых ориентирована и Методика расчета качественного показателя государственного задания «Комплексный балл публикационной результативности» (КПБР) для научных организаций, подведомственных Минобрнауки России [12]. Для расчета КПБР, по значению которого определяется, на каком уровне эффективности находится организация, используются библиометрические показатели, отражающие уровень цитируемости и статус научных журналов. Методика учитывает разные типы публикаций, включая статьи в базах WoS (Core Collection; RSCI), Scopus, Перечня ВАК и монографии, зарегистрированные в Книжной палате. При этом наибольшие баллы начисляются за публикации в изданиях МНБД, а публикации РИНЦ вообще не берутся в расчет, ибо, по мнению разработчиков методики, существуют сложности с контролем их качества.

Курс на интеграцию российских исследований в мировое пространство и подготовку высокорейтинговых публикаций закреплен и новой Программой фундаментальных научных исследований (ПФНИ) [13], которая разработана Российской академией наук при участии профильных министерств и ведущих научных организаций страны. Несмотря на то, что основные задачи ПФНИ связаны с развитием интеллектуального потенциала российской науки, созданием эффективной системы управления научными исследованиями для повышения их значимости и востребованности для национальной экономики, для оценки результатов деятельности российских исследователей заложено сразу несколько показателей МНБД. Таким образом, имеет место регулятивное противоречие: по содержанию ПФНИ является национально ориентированной, а по контрольным цифрам – «чужой», учитывающей результаты российских исследователей на иностранных информационных площадках.

9. Скрытые угрозы процедур оценивания качества НЭЖ

К началу XXI века наука превратилась в массовый вид деятельности, а глобальная цифровизация привела к беспрецедентной демократизации рынка научных изданий, в том числе НЭЖ. Емкость мирового рынка НЭЖ настолько велика, что исключает возможность его мониторинга даже в малой части. В этих условиях можно отслеживать только избранные, наиболее достойные научные издания, для чего их необходимо знать. Одновременно с этим публиковаться имеет смысл также лишь в строго определенном перечне журналов; в противном случае почти нет шансов на то, что статью заметит научная общественность. Кроме того, массовый характер научной деятельности привел к тому, что научная сфера превратилась в обычную отрасль экономики, которая подчиняется всем нормам хозяйствования: в науку вкладывают деньги, а она должна их оправдывать. Такое положение дел приводит к необходимости появления новых маркеров, которые обозначили бы истинное место конкретного исследователя, научного журнала и научной организации. Для этого используются разнообразные рейтинги, в том числе рейтинги НЭЖ.

Однако практика использования рейтингов НЭЖ регулятором для проведения научной политики показывает, что этот процесс таит в себе серьезную опасность для отечественной науки. Например, ориентация российского регулятора на МНБД ставит «под удар» многие российские НЭЖ, не имеющие международной сертификации, но поддерживающих высокие академические стандарты. В условиях, когда российских исследователей «заставляют» публиковаться в НЭЖ, индексируемых в МНБД, несертифицированные отечественные журналы теряют авторов, вытесняются на периферию и фактически лишаются будущего.

Использование государством неадекватных, неправильных или «бракованных» научных маркеров (рейтингов) способно привести и к другим крайне негативным последствиям. Это и массовая практика манипулирования и мошенничества с базами данных, когда исследователи и организации искусственно «накачивают» свои индексы цитирования. Это и формирование «мусорных» и «хищнических» журналов в МНБД, собирающих «дань» со своих авторов. Это и возникновение своеобразных Интернет-ярмарок по оказанию услуг исследователям в публикации статей в высококвартильных журналах (Q1 и Q2); после очередной «чистки» своих рядов базой Scopus цены на означенные услуги резко возросли, что ведет к огромным и неоправданным затратам на ненужные бизнес–операции со стороны российских респондентов.

Особый урон наносит установление заведомо «ложных» и невыполнимых целей: например, предварительные расчеты авторов показывают, что многие российские НЭЖ, входящие в базу WoS, по своим библиометрическим параметрам могут претендовать на место в квартилях уровня Q2–Q4, но по политическим причинам американский собственник базы «консервирует» эти журналы на стадии пребывания в статусе Emerging Sources Citation Index (ESCI). Одновременно с этим публикация российскими экономистами своих статей в зарубежных высококвартильных НЭЖ также чрезвычайно затруднена по политическим причинам. Таким образом, установление в качестве обязательных нормативов исследователям и организациям требования по размещению статей в журналах уровня Q1 и Q2 базы WoS радикально искажает их мотивацию вплоть до полного паралича творческой активности.

10. Заключение

Наличие определенных проблем при применении рейтингов НЭЖ в практике управления наукой вовсе не означает, что от данного инструментария следует отказаться. Скорее, наоборот – применение рейтингов необходимо и пока безальтернативно. Главное – соблюдение двух условий: правильного использования правильных рейтинговых топ–листов. Выше мы показали, что инструментальная основа для решения обозначенных проблем имеется.

В российской практике уже имеется опыт рейтингования отечественных НЭЖ с учетом не только данных базы РИНЦ, но и с учетом их вхождения в МНБД (Балацкий, Екимова, 2018б), а также наличия у изданий англо- и русскоязычной версий публикуемых статей (Балацкий, Екимова, 2019). Тем самым главная задача видится в создании достаточно широкого пула российских НЭЖ, имеющих высокое качество и международный статус. Учитывая аппарат построения гибридных и консолидированных рейтингов, есть реальная возможность осуществить вполне адекватную и непредвзятую оценку качества отечественных НЭЖ.

В более длительной перспективе представляется целесообразным объединение усилий государства и научного сообщества России по созданию национальной реферативно–аналитической системы, которая могла бы стать конкурентоспособной альтернативой уже существующим МНБД.

Список литературы

Алескеров Ф.Т., Писляков В.В., Субочев А.Н., Чистяков А.Г. (2011). Построение рейтингов журналов по менеджменту с помощью методов теории коллективного выбора. Препринт WP7/2001/04. М.: НИУ ВШЭ. (http://www.repnoe.net/docs/materialy-aleskerova-f-t/WP7_2011_04_final.pdf - Дата обращения: 21.01.21).

Алескеров Ф.Т., Писляков В.В., Субочев А.Н. (2013). Построение рейтингов журналов по экономике с помощью методов теории коллективного выбора. Препринт WP7/2013/03. М.: НИУ ВШЭ. (https://www.hse.ru/data/2013/03/11/1293475892/WP7_2013_03_f.pdf - Дата обращения: 21.01.21).

Алескеров Ф.Т., Бадгаева Д.Н., Писляков В.В., Стерлигов И. А., Швыдун С.В. (2016). Значимость основных российских и международных журналов: сетевой анализ // Журнал Новой экономической ассоциации, № 2(30), с. 193–205. DOI: 10.31737/2221-2264-2016-30-2-10.

Аукуционек С., Чуркина Г. (2002). Экономические журналы в период рыночных реформ // Вопросы экономики, № 2, с.130–145.

Балацкий Е.В., Екимова Н.А. (2015). Опыт составления рейтинга российских экономических журналов // Вопросы экономики, № 8, с. 99–115. DOI: 10.32609/0042-8736-2015-8-99-115.

Балацкий Е.В., Екимова Н.А. (2017). Конкуренция экономических журналов России: итоги трех волн рейтингования // Экономическая политика, т. 12, № 6, с. 178–201. DOI: 10.18288/1994-5124-2017-6-09.

Балацкий Е.В., Екимова Н.А. (2018а). Консенсусный рейтинг российских экономических журналов: идеология и опыт составления // Журнал институциональных исследований, т. 10, № 1, с. 93–106. DOI: 10.17835/2076-6297.2018.10.1.093-106.

Балацкий Е.В., Екимова Н.А. (2018б). Международный ландшафт рынка российских экономических журналов // Экономические и социальные перемены: факты, тенденции, прогноз, том 11, № 4, с. 110–124. DOI: 10.15838/esc.2018.4.58.7.

Балацкий Е.В., Екимова Н.А. (2019). Конкуренция российских экономических журналов на мировом рынке // Экономические и социальные перемены: факты, тенденции, прогноз, том 12, № 3, с. 124–139. DOI: 10.15838/esc.2019.6.63.8.

Бредихин С.В., Кузнецов А.Ю., Щербакова Н.Г. (2013). Анализ цитирования в библиометрии. Новосибирск: ИВМиМГ СО РАН, НЭИКОН.

Бредихин С.В., Ляпунов В.М., Щербакова Н.Г. (2017а). Структура сети цитирования научных журналов // Проблемы информатики, № 2(35), с. 38–52.

Бредихин С.В., Ляпунов В.М., Щербакова Н.Г. (2017б). Кластерный анализ сети цитирования научных журналов // Проблемы информатики, № 3(36), с. 16–34.

Бредихин С.В., Ляпунов В.М., Щербакова Н.Г. (2018). Спектральный анализ сети цитирования научных журналов // Проблемы информатики, № 2(39), с. 24–40.

Бредихин С.В., Ляпунов В.М., Щербакова Н.Г. (2019). Спектральный анализ сети цитирования научных журналов. Часть II // Проблемы информатики, № 1(42), с. 30–41.

Виноградов А.В., Салицкая Е.А., Салицкий А.И. (2016). Наука и техника в Китае: состоявшаяся модернизация // Вестник Российской академии наук, том 86, № 2, с. 152–160. DOI: 10.7868/S0869587316020158.

Гришакина Е.Г. (2018). Российские журналы через призму наукометрии: краткий обзор журналов, индексируемых в Web of Science и Scopus (c. 30–34) // Научное издание международного уровня – 2018: редакционная политика, открытый доступ, научные коммуникации: материалы 7-й международ. науч.-практ. конф., Москва, 24–27 апреля 2018 г. С. 30–34. DOI: 10.24069/konf-24-27-04-2018.05.

Гусев А.Б., Вершинин И.В., Доронина Е.Г., Малахов В.А. (2018). Мониторинг и оценка результатов научно-технической деятельности: зарубежный опыт и российская практика // Наука. Инновации. Образование, том 27, № 1, с. 65–91.

Мазов Н.А., Гуреев В.Н., Каленов Н.Е. (2018). Некоторые оценки списка журналов Russian Science Citation Index // Вестник Российской академии наук, том 88, № 4, с. 322–332. DOI: 10.7868/S0869587318040047.

Мосичева И.А., Парфенова С.Л. и др. (2018). Дайджест показателей публикационной активности российских исследователей по данным Web of Science, Scopus. Выпуск 1. М.: РИЭПП. (https://riep.ru/activity/publications/drugie-izdaniya/583852/ - Дата обращения: 17.02.2021).

Муравьев А.А. (2013). О научной значимости российских журналов по экономике и смежным дисциплинам // Вопросы экономики, № 4, с. 130–151.

Муравьев А.А. (2015). Рейтинги российских журналов по экономике: сравнительный анализ. (https://studylib.ru/doc/4796527/rejtingi-rossijskih-zhurnalov-po-e-konomike - Дата обращения: 21.01.21).

Рубинштейн А.Я. (2011). Журнал НЭА и его читатели: социологический очерк // Журнал Новой экономической ассоциации, № 12, с. 150–160.

Рубинштейн А.Я. (2014). О журнале НЭА и других экономических журналах: итоги опроса читателей // Журнал Новой экономической ассоциации, № 3(23), с. 175–187.

Рубинштейн А.Я. (2016). Ранжирование российских экономических журналов: научный метод или «игра в цыфирь» // Журнал Новой экономической ассоциации, № 2(30), c. 162–175. DOI: 10.31737/2221-2264-2016-30-2-7.

Рубинштейн А.Я., Бураков Н.А., Славинская О.А. (2017). Сообщество экономистов и экономические журналы (социологические измерения VS библиометрии): Научный доклад. М.: Институт экономики РАН.

Рубинштейн А.Я. (2018). Российские экономические журналы: табель о рангах // Экономическая наука современной России, №1(80), с. 108–130.

Рубинштейн А.Я., Слуцкин Л.Н. (2018). «Multiway data analysis» и общая задача ранжирования журналов. Прикладная эконометрика, 2018, т. 50, с. 90–113.

Субочев А.Н. (2016). Насколько различны существующие рейтинги российских научных журналов по экономике и менеджменту и как их объединить // Журнал Новой экономической ассоциации, № 2(30), с. 181–192. DOI: 10.31737/2221-2264-2016-30-2-9.

Третьякова О.В. (2015). Рейтинг научных журналов экономических институтов РАН // Экономические и социальные перемены: факты, тенденции, прогноз, № 5(41), с. 159–172. DOI: 10.15838/esc/2015.5.41.11.

Третьякова О.В. (2016). Экономический журнал в России: проблемы оценки качества // Экономические и социальные перемены: факты, тенденции, прогноз, том 44, № 2, с. 211–224. DOI: 10.15838/esc.2016.2.44.13.

Третьякова О.В. (2018). Импакт–рейтинг экономических журналов академического сектора: критерии и методика построения // Экономические и социальные перемены: факты, тенденции, прогноз, том 11, № 3, с. 179–194. DOI: 10.15838/esc.2018.3.57.12.

Третьякова О.В. (2020). Оценка журналов RSCI по экономическим наукам в контексте создания национального индекса цитирования // Вестник Российской академии наук, том 90, № 4, с. 364–380. DOI: 10.31857/S0869587320040143.

ABS (2018). Academic Journal Guide. (https://charteredabs.org/academic-journal-guide-2018/ - Дата обращения: 21.01.21).

Aleskerov, F.T., Pislyakov, V.V., Subochev, A.N. (2014). Ranking Journals in Economics, Management and Political Science by Social Choice Theory Methods. HSE Working Papers STI. No 27.

Arrow, K. J. (1951). Social Choice and Individual Values. N. Y.: Wiley.

Axarloglou, K., Theoharakis, V. (2003). Diversity in Economics: An Analysis of Journal Quality Perceptions. Journal of the European Economic Association, vol.1, no. 6, pp. 1402-1423. DOI: 10.1162/154247603322752584.

Barman, S., Tersine, R. J., Buckley, M. R. (1991). An empirical assessment of the perceived relevance and quality of POM-related journals by academicians. Journal of Operations Management, vol. 10, no. 2, pp. 194–212. DOI: 10.1016/0272-6963(91)90022-P.

Barman, S., Hanna, M. D., LaForge, R. L. (2001). Perceived relevance and quality of POM journals: A decade later. Journal of Operations Management, vol. 19, no. 3, pp. 367–385. DOI: 10.1016/S0272-6963(00)00060-7.

Bauerly, R., Johnson, D. (2005). An evaluation of journals used in doctoral marketing programs. Journal of the Academy of Marketing Science, vol. 33, article number 313. DOI: 10.1177/0092070304272052.

Bergstrom, C.T. (2007). Eigenfactor: Measuring the value and prestige of scholarly journals. College and Research Libraries News, vol. 68, no. 5, pp. 314–316. DOI: 10.5860/crln.68.5.7804.

Billings, B.B., Viksnins, G.J. (1972). The relative quality of economics journals: an alternative rating system. Economic Inquiry, vol. 10, no. 4, pp. 467–469. DOI: 10.1111/j.1465-7295.1972.tb01568.x.

Brauninger, M., Haucap, J. (2001). Was Ökonomen Lesen und Schätzen: Ergebnisse einer Umfrage. Perspektiven der Wirtschaftspolitik, vol. 2, no. 2, pp. 185–210. DOI: 10.1111/1468-2516.00044.

Braeuninger, M., Haucap, J., Muck, J. (2011). Was lesen und schaetzen deutschsprachige oekonomen heute? Perspektiven der Wirtschaftspolitik, vol. 12, no. 4, pp. 339–371. DOI: 10.1111/j.1468-2516.2012.00376.x.

Brin, S., Page, L. (1998). The anatomy of a large–scale hypertextual Web search engine. Computer Networks and ISDN Systems, vol. 30, no. 1–7, pp. 107–117. DOI: 10.1016/S0169-7552(98)00110-X.

Bollen, J., Rodriquez, M.A., Van de Sompel, H. (2006). Journal status. Scientometrics, vol. 69, no. 3, pp. 669–687. DOI: 10.1007/s11192-006-0176-z.

Bornmann, L., Buts, A., Wohlrabe, K. (2017). What are the Top Five Journals in Economics? A New Meta-ranking. MPRA Paper No. 79176. (https://mpra.ub.uni-muenchen.de/79176/1/MPRA_paper_79176.pdf - Дата обращения: 21.01.21).

Bush, W.C., Hamelman, P.W., Staaf, R.J. (1974). A quality index for economics journals. The Review of Economics and Statistics, vol. 51, no. 1, pp. 123–25. DOI: 10.2307/1927541.

Button, K., Pearce, D. (1977). What British Economists think of their Journal". International Journal of Social Economics, vol. 4, no. 3, pp. 150–158. DOI: 10.1108/eb013812.

Chang, C.-L., Maasoumi, E., McAleer, M. (2016). Robust ranking of journal quality: An application to economics. Econometric Institute Report. Econometric Reviews, vol. 35, no. 1, pp. 50–97. DOI: 10.1080/07474938.2014.956639.

Claar, V., Gonzalez, R. (2014). Ranking the Rankings of Journals in Economics by Quantifying Journal Demand. Southwestern Economic Review, vol. 41, no. 1, pp. 79–88. (https://ssrn.com/abstract=2749331 - Дата обращения: 21.01.21).

Coats, A.W. (1971). The role of scholarly journals in the history of economics. Journal of Economic Literature, vol. 9, no. 1, pp. 29–44.

Cook, W.D., Ravin, T., Richardson, A.J. (2010). Aggregating Incomplete Lists of Journal Rankings: An Application to Academic Accounting Journals. Accounting Perspectives, vol. 9, no. 3, pp. 217–235. DOI: 10.1111/j.1911-3838.2010.00011.x.

Currie, R.R., Pandher, G.S. (2011). Finance journal rankings and tiers: an active scholar assessment methodology. Journal of Banking & Finance, vol. 35, no. 1, pp. 7–20. DOI: 10.1016/j.jbankfin.2010.07.034.

Currie, R.R., Pandher, G.S. (2020). Finance journal rankings: Active scholar assessment revisited. Journal of Banking & Finance, vol. 111, article no. 105717. DOI: 10.1016/j.jbankfin.2019.105717.

De Solla Price, D.J. (1965). Networks of scientific papers. Science, vol. 149, no. 3683, pp. 510–515. DOI: 10.1126/science.149.3683.510.

Ding, Y., Yan, E., Frazho, A., Caverlee, J. (2009). PageRank for ranking authors in co–citation networks. Journal of the American Society for Information Science and Technology, vol. 60, no. 11, pp. 2229–2243. DOI: 10.1002/ASI.21171.

Ding, Y. (2011). Applying weighted PageRank to author citation networks. Journal of the American Society for Information Science and Technology, vol. 62, no. 2, pp. 236–245. DOI: 10.1002/ASI.21452.

Dondio, P., Casnici, N., Grimaldo, F., Gilbert, N., Squazzoni, F. (2019). The “invisible hand” of peer review: The implications of author–referee networks on peer review in a scholarly journal. Journal of Informetrics, vol. 13, no. 2, pp. 708–716. DOI: 10.1016/j.joi.2019.03.018.

Doreian, P. (1985). A measure of standing of journals in stratified networks. Scientometrics, vol. 8, no. 5–6, pp. 341–363. DOI: 10.1007/BF02018058.

Doreian, P. (1987). A revised measure of standing of journals in stratified networks. Scientometrics, vol. 11, no. 1–2, pp. 71–80. DOI: 10.1007/BF02016631.

Enomoto, C., Ghosh, S. (1993). A stratified approach to the ranking of economics journals. Studies in Economics and Finance, vol. 14, no. 2, pp. 74–94. DOI: 10.1108/eb028705.

Franceschet, M. (2011). PageRank: Standing on the shoulders of giants. Communications of the ACM, vol. 54, no. 6, pp. 92–101. DOI: 10.1145/1953122.1953146.

Fry, T.D., Donohue, J.M. (2013). Outlets for operations management research: a DEA assessment of journal quality and rankings. International Journal of Production Research, vol. 51, no. 23–24, pp. 7501–7526. DOI: 10.1080/00207543.2013.783245.

Garfield, E. (1955). Citation Indexes to Science: a New Dimension in Documentation Through Association of Ideas. Science, vol. 122, no. 3159, pp. 108–111. DOI: 10.1126/science.122.3159.108.

Garfield, E. (1973). The new ISI journal citation reports should significantly affect the future course of scientific publication. Essays of an Information Scientist, vol. 1, pp. 473–474.

Geller, N.L. (1978). On the citation influence methodology of Pinski and Narin. Information Processing and Management, vol. 14, no. 2, pp. 93–95. DOI: 10.1016/0306-4573(78)90066-3.